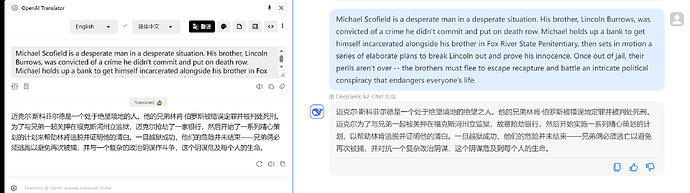

不错的模型也就deepseekv2 还有yi-1.5-34b,用来跑翻译正好![]()

官方没有给这方面的文档,不过试了下沉浸式翻译速度还行。

响应速度挺快,不知道deepseek v2和deepseek api比起来能力有没有差别

官方的api映射的也是这个v2模型吧,能力应该没区别

官方说开源的是128k而api是32k,不知道这个怎么样

他这个是自己跑的开源模型还是买的api

长文本成本直接上去了吧?显存不够使了

自己跑的,都是些开源模型

如果是128k且响应速度还这么快的话真是吊打deepseek官方的api了

自己跑的啊,那236b咋比那110b的还便宜

不知道啊

236b的v2是MOE模型,跑起来没有110b费劲的

原来如此!谢谢

这个咋请求啊

base_url:https://api.siliconflow.cn

api:填自己的

model:deepseek-ai/deepseek-v2-chat

deepseek-ai/deepseek-llm-67b-chat

alibaba/Qwen1.5-110B-Chat

alibaba/Qwen1.5-32B-Chat

alibaba/Qwen1.5-14B-Chat

alibaba/Qwen1.5-7B-Chat

01-ai/Yi-1.5-34B-Chat

01-ai/Yi-1.5-9B-Chat

01-ai/Yi-1.5-6B-Chat

zhipuai/chatglm3-6B

meta/llama3-70B-chat

meta/llama3-8B-chat

mixtralai/Mixtral-8x22B-Instruct-v0.1

mixtralai/Mixtral-8x7B-Instruct-v0.1

mixtralai/Mistral-7B-Instruct-v0.2

google/gemma-7b-it

microsoft/Phi-3-mini-4k-instruct

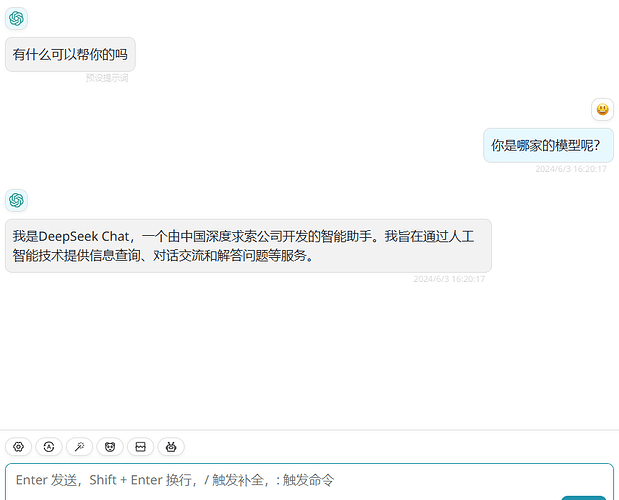

你在next-web之类的应用内也可以用嘛,我只能在openai-translator或者curl调用是正常的。

谢谢,我这还是不行。配置都是正常的,curl可以正常调用。但在应用里配置就failed to fetch,one-api中转也是一样。

ps: 这里面我curl也只有一部分模型可以调用,像mixtralai/Mixtral-8x22B-Instruct-v0.1我直接报非法参数。

那奇怪了,试试lobehub,沉浸式翻译之类的能正常调用吗?我的nextchat确实是可以正常调用的。配置就是图上这样