Llama-3-70B-Instruct

今天看到的几个模型对比里面,这个模型算是排在前列

但是没有找到提供的地方

这个模型那家可以白嫖一点

grop加进去好像不支持

1 个赞

最近也在玩这个 奈何电脑只能带动7B

前排。

1 个赞

ollama正解

本地跑起来很方便,各种模型都有,就是配置不够只能跑9B以下

我8核16g可以跑个什么玩![]()

7b

就跑过8b,五秒一个字,还是找直接提供API的吧

不好用啊,我接 groq的 llama3.1 70b 效果都很一般,比起 claude3.5 和 4o 差距还是太大,拿来娱乐可以,工作不行

llama中文社区

![]() 不用gpu吧。笔记本。哈哈

不用gpu吧。笔记本。哈哈

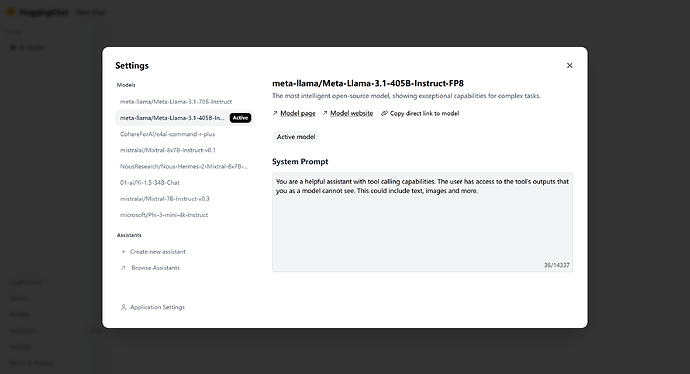

抱脸可以试用

我接了

感谢分享这么多的试用链接

groq 有 70b-versatile

啊/ ![]()

现在用的8192那个

From #develop:ai to 资源荟萃