但是我会尝试去做的

支持佬友![]()

佬友,向你请教下,这种二开同步官方功能的时候是一个一个手动看的吗

佬 我有两个问题

-

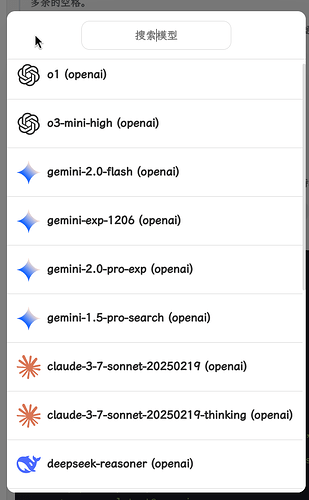

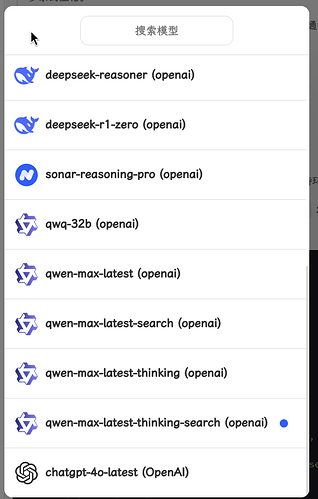

第一个是模型顺序的

我这样设置的环境变量

CUSTOM_MODELS: -all,+chatgpt-4o-latest@openai,+o1@openai,+o3-mini-high@openai,+gemini-2.0-flash@openai,+gemini-exp-1206@openai,+gemini-2.0-pro-exp@openai,+gemini-1.5-pro-search@openai,+claude-3-7-sonnet-20250219@openai,+claude-3-7-sonnet-20250219-thinking@openai,+deepseek-reasoner@openai,+deepseek/deepseek-r1-zero:free@openai=deepseek-r1-zero,+sonar-reasoning-pro@openai,+qwq-32b@openai,+qwen-max-latest@openai,+qwen-max-latest-search@openai,+qwen-max-latest-thinking@openai,+qwen-max-latest-thinking-search@openai但是我看web界面里面顺序和我环境变量顺序不一样

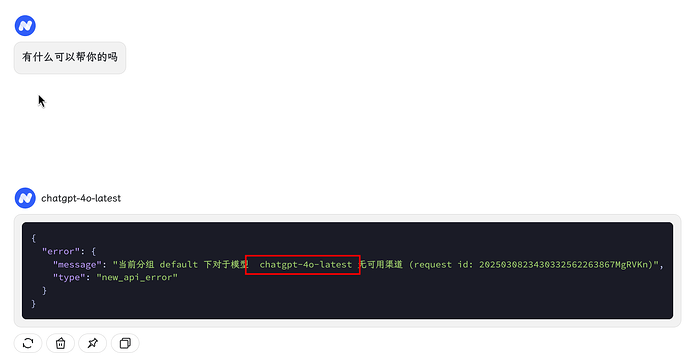

chagpt-4o-latest这个模型为什么会在最后面

-

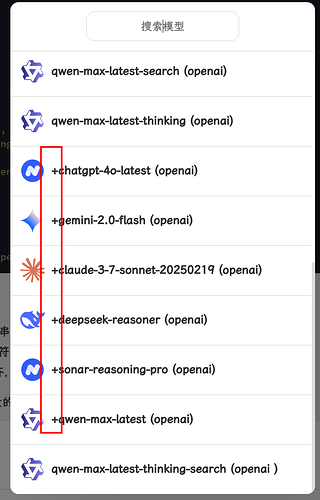

第二个是关于优化环境变量读取的,比如我的docker compose中模型的环境变量,为了方便区别,分行进行书写

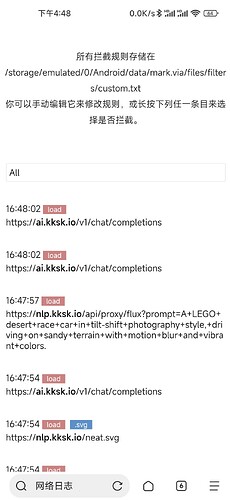

services: chatgpt-next-web: image: tianzhentech/chatgpt-next-web:latest container_name: chatgpt-next-web restart: always ports: - 1000:3000 environment: OPENAI_API_KEY: sk-yB CODE: 8 BASE_URL: https://new-api.org CUSTOM_MODELS: > -all, +chatgpt-4o-latest@openai,+o1@openai,+o3-mini-high@openai, +gemini-2.0-flash@openai,+gemini-exp-1206@openai,+gemini-2.0-pro-exp@openai,+gemini-1.5-pro-search@openai, +claude-3-7-sonnet-20250219@openai,+claude-3-7-sonnet-20250219-thinking@openai, +deepseek-reasoner@openai,+deepseek/deepseek-r1-zero:free@openai=deepseek-r1-zero, +sonar-reasoning-pro@openai,+qwq-32b@openai, +qwen-max-latest@openai,+qwen-max-latest-search@openai,+qwen-max-latest-thinking@openai,+qwen-max-latest-thinking-search@openai #CUSTOM_MODELS: -all,+chatgpt-4o-latest@openai,+o1@openai,+o3-mini-high@openai,+gemini-2.0-flash@openai,+gemini-exp-1206@openai,+gemini-2.0-pro-exp@openai,+gemini-1.5-pro-search@openai,+claude-3-7-sonnet-20250219@openai,+claude-3-7-sonnet-20250219-thinking@openai,+deepseek-reasoner@openai,+deepseek/deepseek-r1-zero:free@openai=deepseek-r1-zero,+sonar-reasoning-pro@openai,+qwq-32b@openai,+qwen-max-latest@openai,+qwen-max-latest-search@openai,+qwen-max-latest-thinking@openai,+qwen-max-latest-thinking-search@openai networks: - homelab-network networks: homelab-network: external: true一些模型的模型名称前面就会出现

+,因为部署后的容器读取到的环境变量变成了这样,换行后有空格出现-all, +chatgpt-4o-latest@openai,+o1@openai,+o3-mini-high@openai, +gemini-2.0-flash@openai,+gemini-exp-1206@openai,+gemini-2.0-pro-exp@openai,+gemini-1.5-pro-search@openai, +claude-3-7-sonnet-20250219@openai,+claude-3-7-sonnet-20250219-thinking@openai, +deepseek-reasoner@openai,+deepseek/deepseek-r1-zero:free@openai=deepseek-r1-zero, +sonar-reasoning-pro@openai,+qwq-32b@openai, +qwen-max-latest@openai,+qwen-max-latest-search@openai,+qwen-max-latest-thinking@openai,+qwen-max-latest-thinking-search@openai,佬你这可以解决一下吗

现在已经不打算同步了,与官方差异过大,手动合并不现实,以后有官方非常好的功能会抄一下,本分支会坚持精简,符合移动端交互的前提下,慢慢补充一些关键功能,然后养老。虽然我感觉nextchat的轻量和吐字飞快仍然是优点,但是现在agent发展这么快,有时候禁不住对比,nextchat遗留的问题也很多,当初选择nextchat的唯一原因也是因为对服务器性能要求不高,然后吐字知道今天仍然是第一梯队,你看openwebUI那个还用ws,nginx等等优化来优化去,仍然还是解决不了吐字动画的问题,很奇怪好吧,我忍受不了这一点。

nc至少能做到和newapi上游一样的流入流出速度,不损失tps

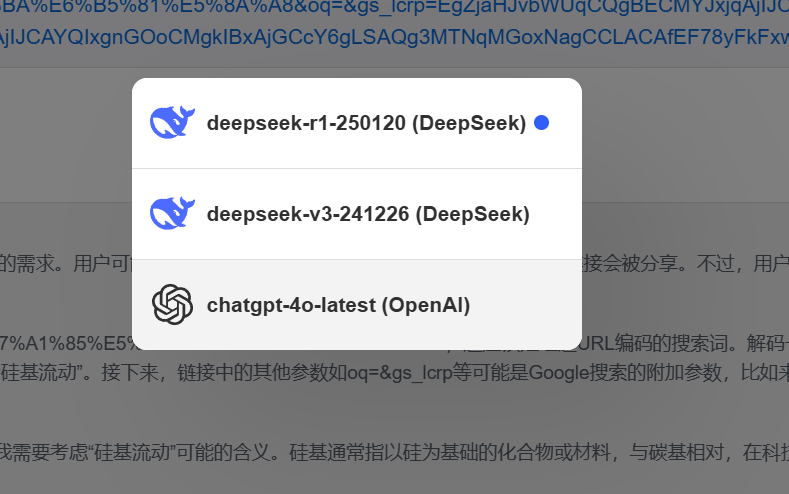

-all之后,不用再加+了,直接跟模型名称,像这样

CUSTOM_MODELS=-all,deepseek-r1-250120@DeepSeek,deepseek-v3-241226@DeepSeek

而且后面建议跟模型系列,后续版本我会取消@请求格式这种做法,而是建议@模型系列

因为都@openai很奇怪,尤其是现在已经很弱化openai的情况下,而且不便于模型排名和模型图标的匹配

后面我会尝试用

deepseek-r1-250120@DeepSeek这种格式,@后面跟模型系列,也即头像

我全部接入new-api,不过我是在nextchat试的,不完全兼容插件,会有bug

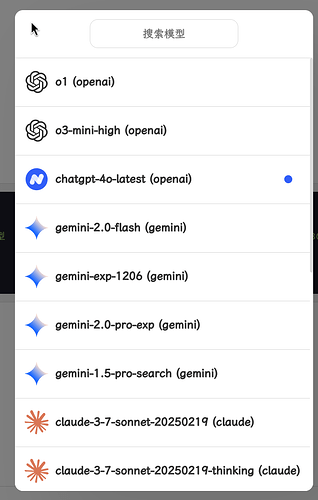

佬 我按照你说的更改了docker compose,第一个问题是解决了,模型顺序正确了

services:

chatgpt-next-web:

image: tianzhentech/chatgpt-next-web:latest

container_name: chatgpt-next-web

restart: always

ports:

- 10179:3000

environment:

OPENAI_API_KEY: sk-yBJ2

CODE: 8

BASE_URL: https://new-api.org

CUSTOM_MODELS: >

-all,

chatgpt-4o-latest@openai,o1@openai,o3-mini-high@openai,

gemini-2.0-flash@gemini,gemini-exp-1206@gemini,gemini-2.0-pro-exp@gemini,gemini-1.5-pro-search@gemini,

claude-3-7-sonnet-20250219@claude,claude-3-7-sonnet-20250219-thinking@claude,

deepseek-reasoner@deepseek,deepseek/deepseek-r1-zero:free@deepseek=deepseek-r1-zero,

sonar-reasoning-pro@perplexity,

qwen-qwq-32b@qwen,qwq-32b@qwen,qwen-max-latest@qwen,qwen-max-latest-search@qwen,qwen-max-latest-thinking@qwen,qwen-max-latest-thinking-search@qwen

#CUSTOM_MODELS: -all,chatgpt-4o-latest@openai,o1@openai,o3-mini-high@openai,gemini-2.0-flash@openai,gemini-exp-1206@openai,gemini-2.0-pro-exp@openai,gemini-1.5-pro-search@openai,claude-3-7-sonnet-20250219@openai,claude-3-7-sonnet-20250219-thinking@openai,deepseek-reasoner@openai,deepseek/deepseek-r1-zero:free@openai=deepseek-r1-zero,sonar-reasoning-pro@openai,qwq-32b@openai,qwen-max-latest@openai,qwen-max-latest-search@openai,qwen-max-latest-thinking@openai,qwen-max-latest-thinking-search@openai

networks:

- homelab-network

networks:

homelab-network:

external: true

不过为什么chatgpt-4o-latest不显示logo

第二个问题依旧存在,多余的空格会让nextchat请求错误的模型

现在这个模型头像匹配还是不方便,我后面会更新让它@什么就显示什么系列的头像

我没有动过这方面的代码,你是说你在.env里-all,然后自定义模型之后,又在这个网页处-all,不能清除是吧。这个原来的nextchat也有?原来的这个-all可能官方的用意只是用来清除展示模型的,我没有想过这样使用。这个-all很奇怪,我后面一定会做一个自动获取模型的按钮,然后选择模型展示。-all太奇怪了。

我的意思是在.env里设置-all后,在网页处添加的自定义模型不会出现在列表里面,不过后面自动获取模型不用-all应该就能添加了

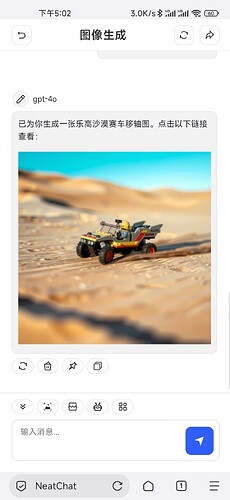

插件似乎已经可以了,你再试试,我只测试了解析url和ddg联网这两个插件,暂时还没上相关的动画。你帮我测测其他的有问题吗,后面我会预装几个插件

无痕模式呢

这个插件调用的动画是很久之前就有吗(15.8及以前?),奇怪我恢复相关代码之后,动画是没有的,可能之前某一次改动把这个误删了,我想办法加一下吧