100积分一次

引用内容非常多

感谢大佬测试

里面还是有很多幻觉,比如治大国若烹小鲜,这个是道德经里面的,是老子说的

简单的去考证了一下这篇文档的学术严谨性(只分析了前几页)。虽然说不上漏洞百出吧,但是作为学术成果来讲,确实很容易出问题。

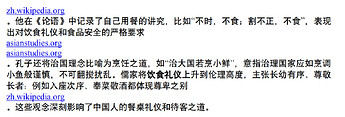

1.首先是楼上佬友提到的“治大国,若烹小鲜”的问题。这句话毫无疑问是出自老子《道德经》和孔子与儒家没有什么关系,就deep research给出的引用来看,大概率出自这篇wiki。wiki本身没出错,gpt理解错了,纯纯的幻觉。

2.”王者以民为本,而民以食为天“这句话是错的

这是因为wiki页面上本来就是错的,这句话实际上是“王者以民为天,而民以食为天”。虽然对理解上没什么太大差异,但是在学术研究里,这个错误就很重要。这可能也是为什么很多导师都不建议在wiki或者百度这种百科上做参考的原因吧。

不过这里也可能是古文典籍本身存在抄写差异的问题,但我在考察的时候没发现《汉书》别本里有”王者以民为本“的叙述情况。姑且也当如此。

3.关于“最负盛名”的说法

gpt o1-pro给出的答案如下。

o1-pro的说法大概是正确的。但这倒不是deep research的问题了,是信息源的问题。这一堆163的参考网站,可靠性真的很不行。且不说这些自媒体公众号很多文章本身就是gpt生成的,如果是用4o这类模型生成的倒还好了。但实际上有太多小编用的各种国内大模型和国外大模型混一起的屎汤跑出来的文本。自己也不加以考证。这信息源本身就是错的,research出来的东西又怎么可靠。

总而言之,deep research自己存在幻觉,如“治大国”的问题。还有就是不会交叉印证,如果有的话,很容易就会发现现在通行的《汉书》原本说的到底是“王者以民为本”还是"王者以民为天“,而不会直接择取wiki上的原文。最后也就是文献引用的随意性。翻163的自媒体网页。。跟看百家号有什么区别,如果没有可靠信源和交叉印证作为依据的话。OpenAI官网所叙述的save 4 hours,恐怕也要花上few hours在验证信源上。

总之路漫漫而修远兮啊,希望能不断进步吧。

能给出来源就能去确认,这点比模型直接编要好的多了,也算是进步了

是啊,其实现在希望gpt先不考虑整一个deep research的全方位文本。感觉先搞出来个多方信源交叉引证反而更实用和可靠一些。

另一个很关键的点就是真正有信息价值的地方,却爬不到。不知道英文调查研究效果如何。反正在中文这块,有价值的信息全都在私域流量里,不给爬真的太伤了。

也就那个样子吧

英文内容确实要好很多,GPT 可以帮忙找英文资料,然后用中文报告,这点也很实用。有些 AI 搜索也是查英文内容,然后 AI 中文总结,所以很好用。

听说深度研究擅长的是数据方面的工作,比如金融、行业研报等方面,老哥你要不试一下这些方面的,社科方面我一直觉得ai不太擅长,幻觉严重

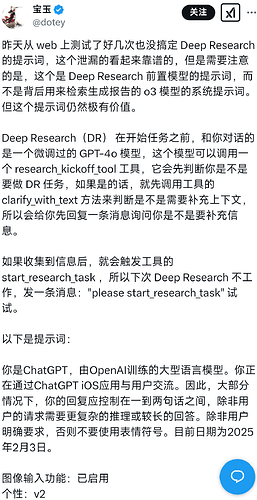

先确认任务是正常的,官方演示视频里就是这样。

听起来有点像gemini那个

怎么使用的?我也想试试。

chat01能适配吗。deep research ,能的话就准备订阅了 ![]()

可以的,在搞了

什么时候能对接学术文献搜索引擎并能下载论文读论文并且交叉验证不产生幻觉这个功能才能实用。

Genspark 好像前幾天也出了一個