上期帖子:

现在,给你的小羊驼穿件衣服吧~

A.开始准备

- windows docker安装指南:

Windows | Docker Docs

当然,针对小白,我专门写了个Docker简易安装指南请查看 :

当然,针对小白,我专门写了个Docker简易安装指南请查看 :

- OpenWebUI项目链接:

官网:

https://openwebui.com/

GitHub:

GitHub - open-webui/open-webui: User-friendly AI Interface (Supports Ollama, OpenAI API, ...)

B.开始部署

- 备注事项:

- 我们使用的是本机部署方式,不同服务器我会写在后续进阶中

- 建议配置docker镜像加速,因为接下来使用的镜像很大!为了教程更简单,我在此不配置,直接在命令中使用南京大学镜像站

ghcr.nju.edu.cn拉取镜像

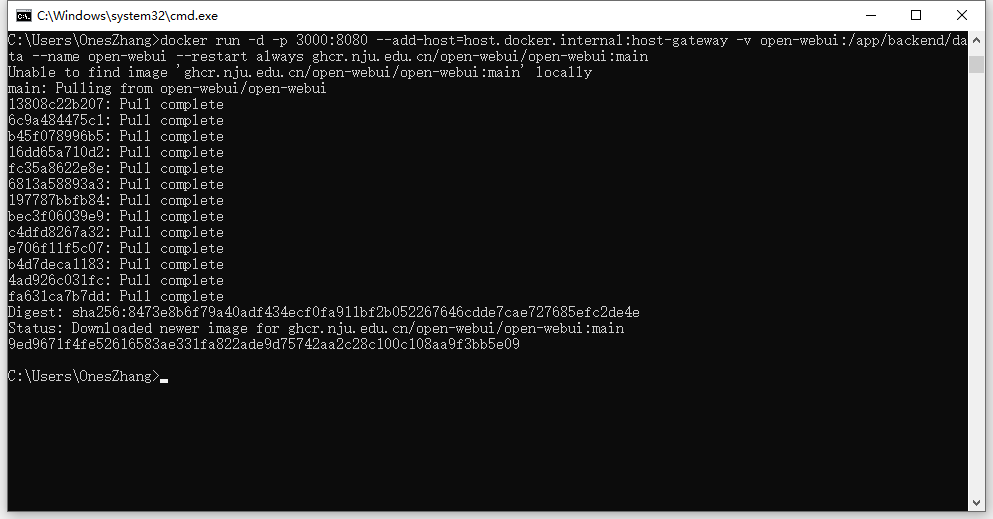

- 打开你的Windows 命令提示符(CMD),运行以下命令:

docker run -d -p 3000:8080 --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always ghcr.nju.edu.cn/open-webui/open-webui:main

点击查看命令解释

# 运行 Docker 容器并将容器内部的 8080 端口映射到宿主机的 3000 端口

docker run -d -p 3000:8080 \

# 添加一个自定义的主机名映射,将 host.docker.internal 映射到容器的主机网关

--add-host=host.docker.internal:host-gateway \

# 将容器内的 /app/backend/data 目录挂载到名为 open-webui 的卷上,用于持久化数据

-v open-webui:/app/backend/data \

# 指定容器的名称为 open-webui

--name open-webui \

# 指定容器的重启策略为 always,即总是自动重启

--restart always \

# 使用 ghcr.nju.edu.cn 上的 open-webui 镜像的 main 分支(原版是ghcr.io,为了加速,我改为了ghcr.nju.edu.cn)

ghcr.nju.edu.cn/open-webui/open-webui:main

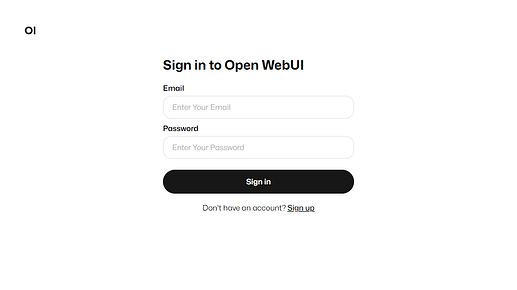

- 部署完成!访问 http://localhost:3000,如果打开了,那么恭喜你,小衣服已经穿好了~

C.开始配置

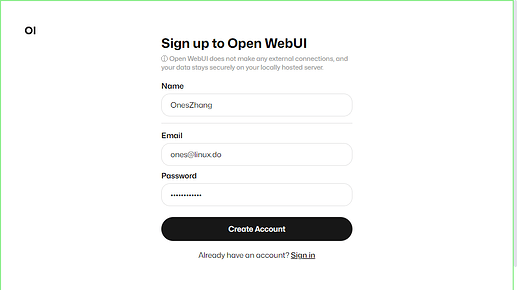

- 点击Sign up,创建一个账号吧~

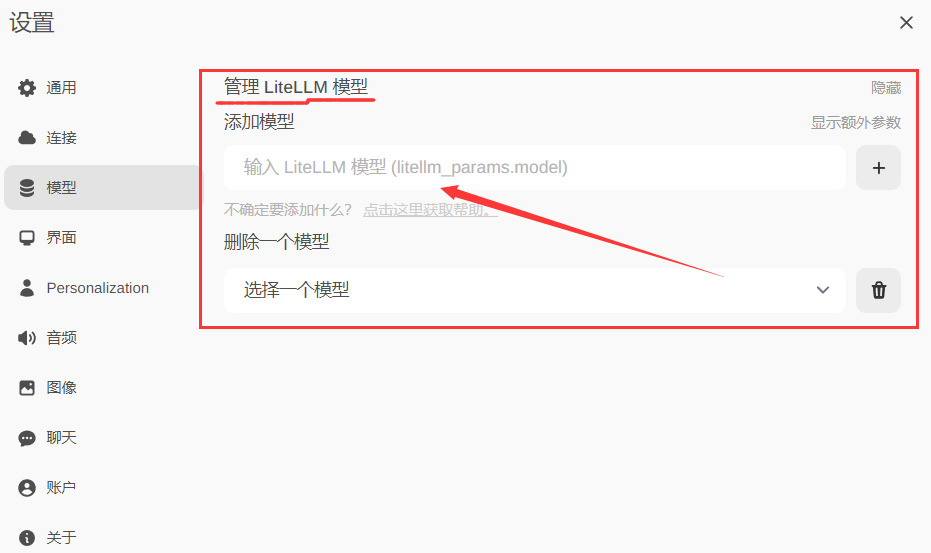

- 设置模型,点击右上角小齿轮~

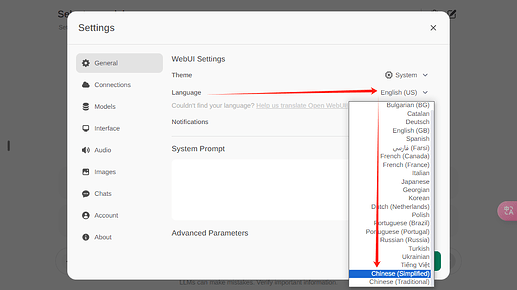

- 切换中文

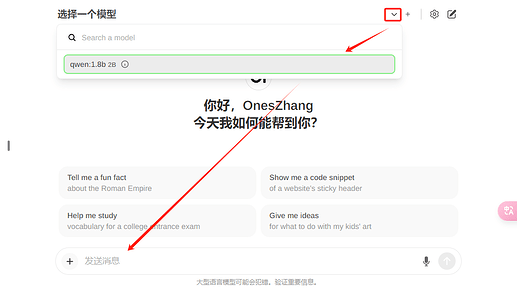

- 模型选项,输入模型名称,点击右侧下载按钮,自动下载安装模型~

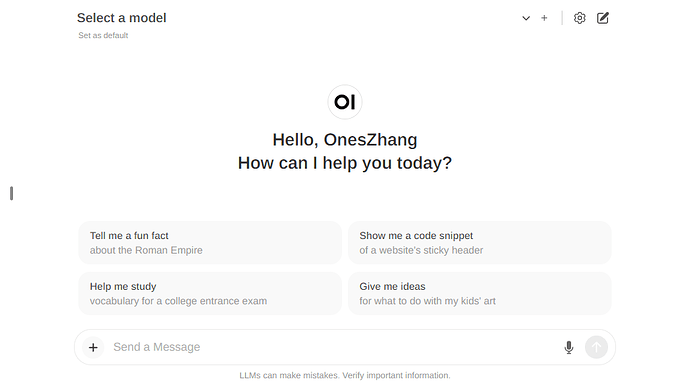

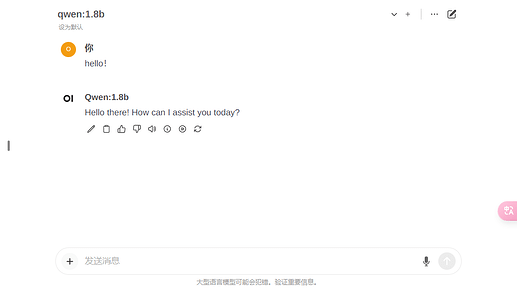

- 选择模型,开始对话~

- 切换中文

恭喜你!开始享受自己部署模型的乐趣吧~

更多技巧慢慢探索吧~官方文档是个好东西

如有不足,还请各佬指导~ ![]()

随着版本飞速迭代升级,本指南可能无法满足你的需求,食用时建议结合官方文档!