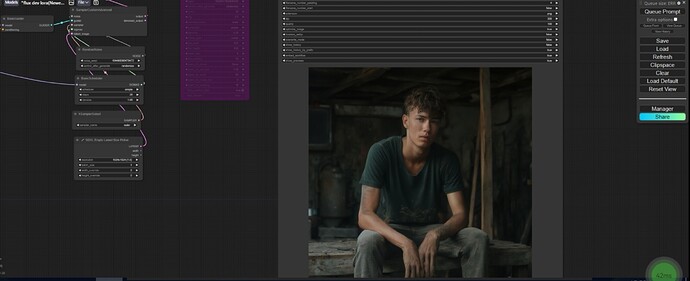

To see the GUI go to: http://127.0.0.1:8188

[ComfyUI-Manager] default cache updated: https://raw.githubusercontent.com/ltdrdata/ComfyUI-Manager/main/model-list.json

[ComfyUI-Manager] default cache updated: https://raw.githubusercontent.com/ltdrdata/ComfyUI-Manager/main/alter-list.json

[ComfyUI-Manager] default cache updated: https://raw.githubusercontent.com/ltdrdata/ComfyUI-Manager/main/custom-node-list.json

[ComfyUI-Manager] default cache updated: https://raw.githubusercontent.com/ltdrdata/ComfyUI-Manager/main/github-stats.json

Exception in thread Thread-1 ():

Traceback (most recent call last):

File “/opt/conda/lib/python3.10/site-packages/aiohttp/connector.py”, line 1173, in _create_direct_connection

hosts = await asyncio.shield(host_resolved)

File “/opt/conda/lib/python3.10/site-packages/aiohttp/connector.py”, line 884, in _resolve_host

addrs = await self._resolver.resolve(host, port, family=self._family)

File “/opt/conda/lib/python3.10/site-packages/aiohttp/resolver.py”, line 33, in resolve

infos = await self._loop.getaddrinfo(

File “/opt/conda/lib/python3.10/asyncio/base_events.py”, line 863, in getaddrinfo

return await self.run_in_executor(

File “/opt/conda/lib/python3.10/concurrent/futures/thread.py”, line 58, in run

result = self.fn(*self.args, **self.kwargs)

File “/opt/conda/lib/python3.10/socket.py”, line 955, in getaddrinfo

for res in _socket.getaddrinfo(host, port, family, type, proto, flags):

socket.gaierror: [Errno -3] Temporary failure in name resolution

The above exception was the direct cause of the following exception:

Traceback (most recent call last):

File “/opt/conda/lib/python3.10/threading.py”, line 1016, in _bootstrap_inner

self.run()

File “/opt/conda/lib/python3.10/threading.py”, line 953, in run

self._target(*self._args, **self._kwargs)

File “/ComfyUI/custom_nodes/ComfyUI-Manager/glob/manager_server.py”, line 1710, in

threading.Thread(target=lambda: asyncio.run(default_cache_update())).start()

File “/opt/conda/lib/python3.10/asyncio/runners.py”, line 44, in run

return loop.run_until_complete(main)

File “/opt/conda/lib/python3.10/asyncio/base_events.py”, line 649, in run_until_complete

return future.result()

File “/ComfyUI/custom_nodes/ComfyUI-Manager/glob/manager_server.py”, line 1707, in default_cache_update

await asyncio.gather(a, b, c, d, e)

File “/ComfyUI/custom_nodes/ComfyUI-Manager/glob/manager_server.py”, line 1694, in get_cache

json_obj = await core.get_data(uri, True)

File “/ComfyUI/custom_nodes/ComfyUI-Manager/glob/manager_core.py”, line 606, in get_data

async with session.get(uri) as resp:

File “/opt/conda/lib/python3.10/site-packages/aiohttp/client.py”, line 1194, in aenter

self._resp = await self._coro

File “/opt/conda/lib/python3.10/site-packages/aiohttp/client.py”, line 578, in _request

conn = await self._connector.connect(

File “/opt/conda/lib/python3.10/site-packages/aiohttp/connector.py”, line 544, in connect

proto = await self._create_connection(req, traces, timeout)

File “/opt/conda/lib/python3.10/site-packages/aiohttp/connector.py”, line 911, in _create_connection

_, proto = await self._create_direct_connection(req, traces, timeout)

File “/opt/conda/lib/python3.10/site-packages/aiohttp/connector.py”, line 1187, in _create_direct_connection

raise ClientConnectorError(req.connection_key, exc) from exc

aiohttp.client_exceptions.ClientConnectorError: Cannot connect to host raw.githubusercontent.com:443 ssl:default [Temporary failure in name resolution]