最近升三级了,发个帖随便说点东西。

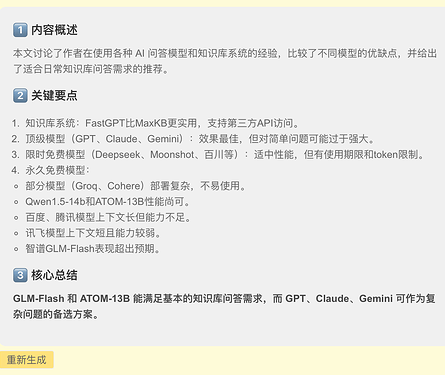

前段时间部署过本地知识库,MaxKB和fastgpt都试了下,发现还是fastgpt好用,而且能在第三方应用上用api访问。MaxKB好像不能自己部署向量模型,只能用默认的,索引效果不怎么样(也可能是我没找到正确使用方法)。

不过现在主要说说关于问答模型的。

gpt,claude,gemini这三家效果肯定是最好的,但很多时候问答都比较简单,用这三个相当于用牛刀杀鸡了,而且像我这样知识库里面放了两百多个文档的,上下文设置的比较大,每次问答一下就要一万多token,属实没必要。而且用大佬们的公益api的话也不够稳定,关键时刻说不定刚好报错。可以作为复杂问答的备用手段。

然后是限时免费或者注册送token的那种,比如deepseek,moonshot,百川等等,差不多算是菜刀了,杀鸡正好,使用效果还是不错的,但是有效期一般1-3个月就没了,而且几百万token其实用的挺快的,每次一两万token的话。另外比如硅基流动,看上去模型多,其实永久免费的都是小模型,送token的部分倒是有大模型,llama 3.1,deepseek之类的。不过还是那个问题,送的容易用完。tokenfree里面的llama 3.1-450B和qwen2-70B标的是32K/128K,实际只有4K,坑啊。api.together也是限额,会用完。

最后是永久完全免费的,稳定肯定是最稳定的,也不存在用完的问题。groq,cohere这些就不说了,部署有那么一点点门槛,也不好用。大善人提供的模型基本也都是小模型,就qwen1.5-14b马马虎虎能用。然后llama family的ATOM-13B倒是还可以,能满足一般使用。剩下的就是百度,腾讯,智谱,讯飞这几个提供永久免费模型的,百度和腾讯就是美工刀,杀鸡杀不动,上下文是够了,但是能力不够强,稍微复杂点的问题就顶不住。讯飞上下文就只有8K,而且能力更差,指甲刀了。最近刚免费的智谱的glm-flash比想象中的好不少,理解能力也强,基本能满足需求。

结论就是,glm-flash和atom-13b能基本知识库问答的日常需求了(当然也看是哪种知识库,代码什么的高级问答那肯定顶不住的)。gpt,claude,gemini三巨头可以作为复杂问题的备用。

32 个赞

发帖格式好奇怪

3 个赞

markdown 没有换行,把文本提取出来吧 ![]()

把前面的空格删了就正常了,我还是太菜了 ![]()

多发帖就掌握技巧了 ![]()

天天又刀刀,好比浪涛

200多文件才1wtoken?

是通过本地向量模型m3e索引的,不需要消耗token。只有问答部分才需要消耗token,因为索引出来的内容多,设置8K不太够,所以我设置上限16K一般就回答的比较精准。

建议佬挂个Rag标签

本地知识库的内容还是太少了!

fastgpt怎么更改索引模型,我只会用默认的002

没找到rag标签,直接在标题上加了

#GraphRAG添加

我是看b站大佬视频部署m3e模型的,大概从17分钟左右开始,然后还需要添加进one api和配置文件里。

不过好像说是bge-large也挺好用的,我没试过,我是看up主用的m3e也就用了。

我也想搞本地知识库,想把微信聊天记录拉下来,有两个问题:

- 微信记录导出难搞,还有图片什么的,一个群聊天太多了,用一些工具导着导着就崩溃了

- 导出后怎么根据每个人进行分类,就是每个人说的话,还有和别人说的话的联系,这些应该以什么规则提取。

这个我不会,我弄的是本地知识库问答,就是把学习资料都放进去做向量索引,然后问答一些知识内容。

有没有完整的教程,想部署玩玩。

有啊,往上爬几楼,我就是看那个b站大佬的视频做的

本地m3e最低要求什么gpu