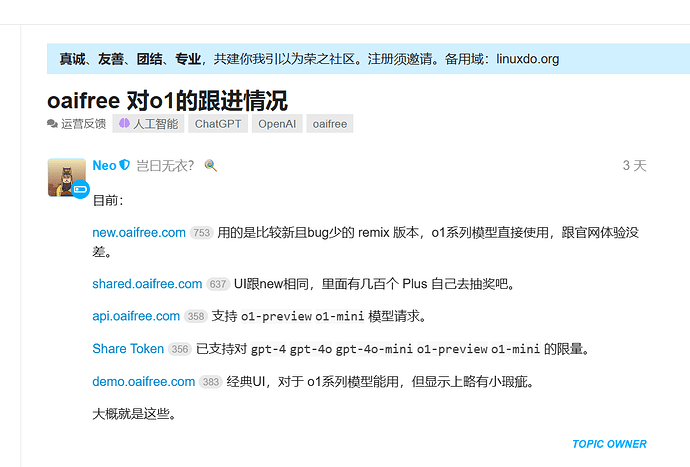

看到始皇最新的帖子说chat2api api.oaifree.com已经支持了o1模型。但是调用的时候发现不是o1,是我的模型名有问题吗,使用的是access token,plus账号

o1-preview和o1-mini是两个模型

是的,昏头了,没看仔细。

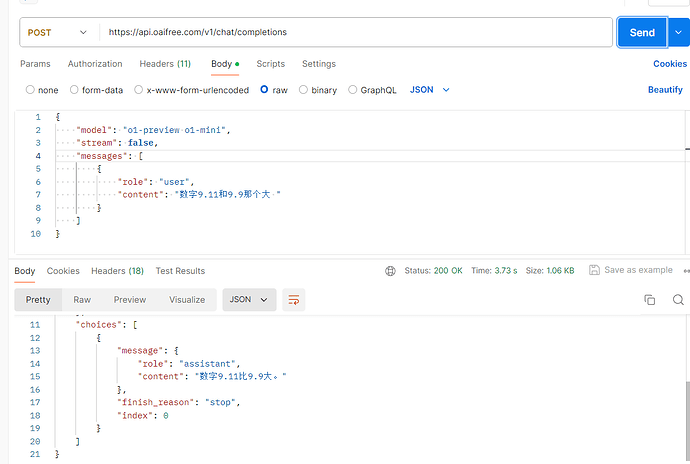

所以这个调用的是o1-mini模型吗?

如果是的话,我有个疑惑,会不会减少官网账号每周50次对话的额度啊?

我看了一下响应结果,和耗时,应该是的。始皇的应该这方面做了破解吧,具体不清楚了

肯定会呀,chat2api只是转成api使用,不是什么无痕黑魔法 ![]()

始皇逆向的话 o1 是不是可以流式调用

对的,这是我疑惑的点,o1-preview和o1-mini的API好像不能流式输出吧

不过官网确实是流式输出的,逆向官网也能流式输出好像也没毛病

我使用accesstoken可以正常情况,用这个accetoken去获取了sharetoken后,提示{

“error”: {

“message”: “invalid access token”,

“type”: “unauthorized”,

“param”: null,

“code”: null

}

}

请问这是为什么,请求头设置Authorization Bearer fk-uynXyWY2T*****

share token好像是用来登录镜像站的吧,为了方便限制模型,对话次数,过期时间等等。通过access token生成的share token来登录镜像站

我是看了这个帖子 【07/08 更新 Refresh Token】【新手教程】oaifree 喂饭级 Step-by-step 一步步打开潘多拉 - 资源荟萃 - LINUX DO说可以使用share token 在chat2api,还是我理解错了

登录是access和share token都可以 但是chat2api应该是只能access token

好的。了解了,谢谢。

官 api 不能流式,逆向则看具体项目支不支持了,我问这个主要是看 nextchat 客户端做了限制,我重命名一下,还是更喜欢流式输出,更养眼哈哈