我整体的项目是想要在comfyui里造一个智能体无代码开发框架。以下是我更新的一个很有趣的节点。如果说能用LLM自动控制一大堆工作流,只要工作流由共建社区上传得足够多,是不是就可以建立一个无所不能的智能体了哈哈哈

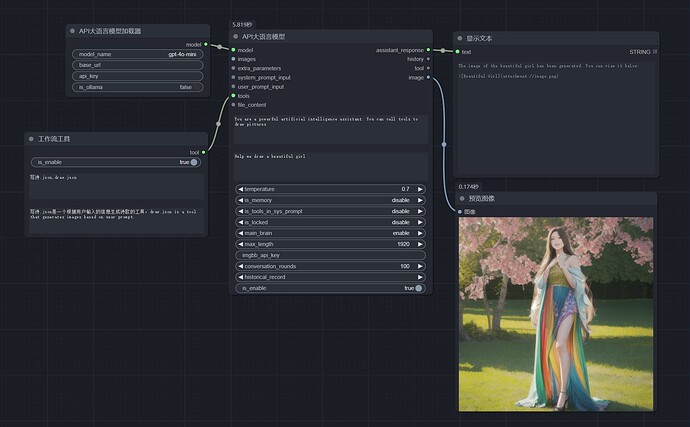

现在你可以将任意的comfyui工作流封装成一个LLM工具节点。你可以让你的LLM同时控制多个comfyui工作流,当你想要他完成一些任务时,他可以根据你的提示,选择合适的comfyui工作流,完成你的任务,并且将结果返回给你。示例工作流:comfyui_workflows_tool。具体步骤如下:

- 首先,将你待会需要被封装成工具的工作流的需要输入文字的接口连上“开始工作流”节点的“user_prompt”输出,这个位置是LLM调用工具时,传入的prompt。在你要输出文字和图片的位置连上“结束工作流”节点的对应输入位置。

- 将这个工作流以API形式保存(需要再设置中开启开发者模式才能看到这个按钮)。

- 将这个工作流保存到本项目的workflow_api文件夹中。

- 重启comfyui,建立一个简单的LLM工作流,例如:start_with_LLM_api。

- 给这个LLM节点添加一个“工作流工具”节点,连在LLM节点的tool输入上。

- 在“工作流工具”节点上,在第一个输入框中写入想要调用的工作流文件名,例如:draw.json,可以写入多个工作流文件名。在第二个输入框中写入每个工作流的作用,这样可以让LLM明白这些工作流怎么用。

- 运行即可看到这个LLM调用你封装好的工作流,并且将结果返回给你。如果返回的是图片,请在LLM节点的image输出上连上“预览图片”节点,查看生成的图片。注意!该方法是在你的8190端口调用了一个新的comfyui,请不要占用这个端口。window和mac系统会有一个新的终端被打开,请不要关闭。Linux系统使用的是screen进程实现的,当你不需要用时,关闭这个screen进程,否则会一直占用你的端口。

项目地址: heshengtao/comfyui_LLM_party: Dify in ComfyUI includes Omost,GPT-sovits, ChatTTS,GOT-OCR2.0, and FLUX prompt nodes,access to Feishu,discord,and adapts to all llms with similar openai/gemini interfaces, such as o1,ollama, qwen, GLM, deepseek, moonshot,doubao. Adapted to local llms, vlm, gguf such as llama-3.2, Linkage neo4j KG, graphRAG / RAG / html 2 img (github.com)

视频教程: 【party节点速览02】将任意工作流变成LLM工具_哔哩哔哩_bilibili