JayXuZ

(JayXuZ)

1

override 使用开源代码补全模型的测试情况 - 资源荟萃 - LINUX DO

上一个帖子中尝试了各类开源模型本地部署情况下搭配 override 实现 github copilot 平替的方案,主要是为了离线开发能够用上比 continue.dev 仅仅是行级补全更好的方案

在今天更新了 qwen2.5-coder:32b 之后赶紧来尝试补全效果

使用的是 ollama 中 32B 默认的

32b-base-q4_K_M 量化模型

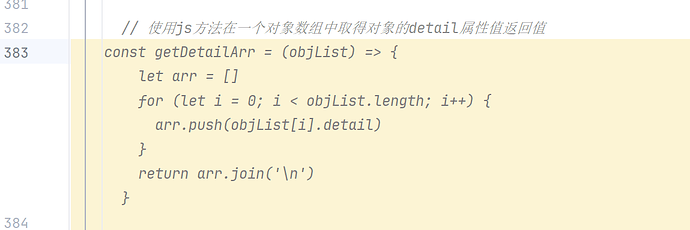

还是跟之前一样尝试在 1000 行代码中插入的注释看能否正常补全

可以看到,虽然代码不够准确优雅,但是达到了可用级别,不会出现之前脑补过度生成注释之外的内容了,模型内存是 20G,实际运行占用如下,大概在 24.3G 左右

大家有条件的可以尝试qwen2.5-coder:32b在内网搭建代码补全服务了

12 个赞

大佬,多分享分享使用,我马上也要用这个方案来实现内网代码补全

你这是4bit量化 考虑到32b本身参数也不算特别大 所以性能损耗应该是还蛮严重的

JayXuZ

(JayXuZ)

5

用量化模型主要还是给大多数人离线部署使用的测试

毕竟完整32B模型66G,普通用户找不到那么大的卡。

我外网能拿来测试的也就这么一块32G的  ,内网倒是大点。

,内网倒是大点。

JayXuZ

(JayXuZ)

6

之前的帖子里面各种小参数开源模型我都试过了,qwen2.5-coder-32B是目前来看唯一可用的。

其他的只能搭配continue.dev用了

如果显存不是问题,deepseek2.5-236B肯定是首选。其次久只能是qwen2.5-coder-32B了

JayXuZ

(JayXuZ)

11

是的,ollama已经支持FIM了,直接/v1/completions就能调用补全方法

1 个赞

K_Martin

(K Martin)

14

qwen的fim感觉要加几个停用词,而且suffix参数不能为空,为空要强制给它加上换行符,不然输出的就不是补全代码

现在是用continue搭配32b gptq int4版本,想问下continue和override,是override更好嘛?

INTJ

(INTJ)

20

试了fp8版本,感觉对于长篇幅code的modify还是远不如Claude3.5

JayXuZ

(JayXuZ)

21

override之后用github copilot肯定是比continue的提示更智能的

continue的联系上下文和其他部分代码的能力感觉不是太好,有点呆。