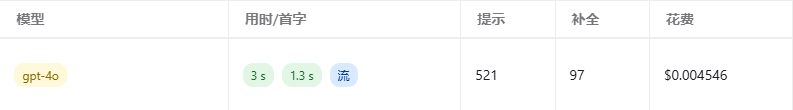

首先搬一个自己的解答帖,关于 4o mini 图文对话的 token 消耗为什么那么大

相同的图片和提问,输入 token 相差却大得惊人:

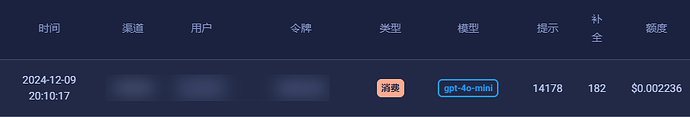

尽管看着很离谱,但这确实是按照官网的计费规则来的,因为 4o mini 的图片 token 计数 base 特别高,导致相同的图片,(输入)消耗的实际 money 甚至比 4o 还要贵一倍

很多前端都有标题生成、历史总结的默认功能,并且多数把 4o-mini 作为默认模型。在多模态模型越来越普遍的情况下,如果 4o mini 的图片计费没有下降,那 4o mini 用来总结上下文的性价比就会变低。

那不如就把这个基础任务模型换成一些更实惠的多模态模型吧,比如这两天刚放出来的 glm-4v-flash 免费 api。当然还有各家大善人们提供的免费 api 也可以考虑进来:gemini 的 flash 模型、groq 的 llama 3.2-90b-vision、mistral 的 pixtral-large、…

欢迎大家补充更多免费的多模态 api