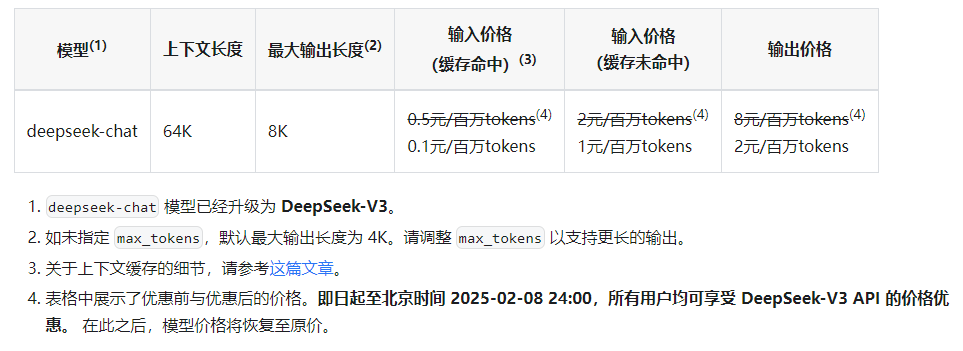

API 涨价了,不过也是意料之中。这个价格在同等级模型下应该还是算比较便宜的。

网页版似乎依旧免费。

模型 API 服务定价也将调整为每百万输入 tokens 0.5 元(缓存命中)/ 2 元(缓存未命中),每百万输出 tokens 8 元

输入 * 2,输出 * 4

缓存 * 5

输出涨得挺多的,要是可以搞个便宜的mini就好了,预设还是v3,然后多一个选择小场景用便宜又比较慢的mini

毕竟涨价提速我是支持的,吐字太慢光是代码补全就赢不了claude使用体验

那可太便宜了。。。

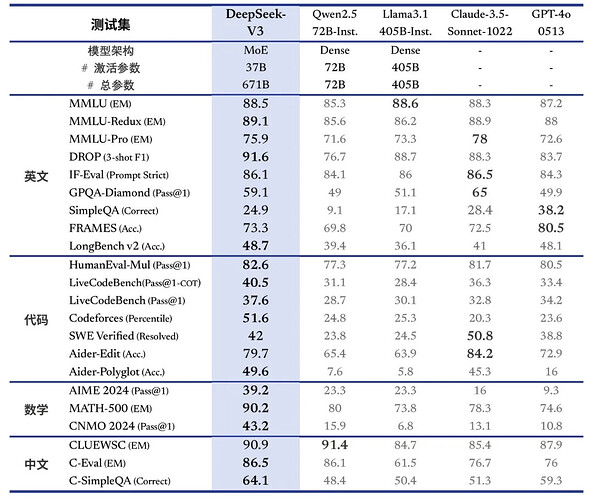

ds-v3

2¥/M tokens input 但有缓存

8¥/M tokens output

glm4 50¥/M tokens (batch半价)没缓存,最拉的一位

yi-lighting 1¥/M tokens 但没缓存,且远弱于 ds-v3,还只有 16k 上下文,完全用不了

openai claude 更别说

目前除了ds-v3只有谷歌flash能说得上是性能好且便宜的

flash

0.6¥/M tokens input

2.2¥/M tokens output

0.15¥/M tokens 缓存

pro 输入输出极其昂贵,但有缓存

9¥/M tokens

36¥/M tokens

2.25¥/M tokens 缓存

支持下,国产模型的进步

V3的api直接整合到原来的DeepSeek chat里了吗

API返回的速度比之前快了一些,还蛮好的

看新闻有说"当前版本的 DeepSeek-V3 暂不支持多模态输入输出。"

意思是V3有要做多模态的计划吗?但是看tech report和repo都没找到跟多模态有关的,所以是跟llama一样的做vision adapter吗?以及report有提到R1,不是R1-Lite了,说明已经有了?其实比较好奇R1的API价格和实际推理成本怎么样?DS老哥要不然透露一下:)

虽然相当便宜,但是这还是涨挺多,是不是涨到正价之后会给多模态

tools 调用还是不好用

其实还好,算便宜了

Gemini pro的中文翻译页面翻错了一个小数点,实际价格应该参考英文界面,输入是便宜十倍的

改了,谷歌也是草台班子 ![]() 我说怎么这么贵

我说怎么这么贵

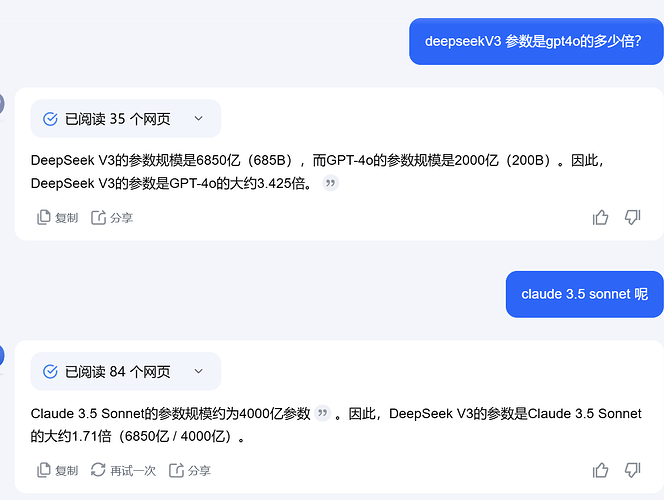

claude 没公布过参数吧

这个kimi联网说的真不靠谱,不过应该比V3 小吧