字节跳动开源 S T A R 视频超分模型:利用 T2V 技术实现高清修复

S T A R 是字节跳动开源的一个利用 T2V(Text-to-Video)模型对视频进行超分辨率的方法。无论是 AI 生成的视频还是现实中的视频,S T A R 都能进行高清修复。预训练模型(基于 I2VGen-XL 和 CogVideoX-5B)及推理代码现已发布,有兴趣的佬友可以自己试试。

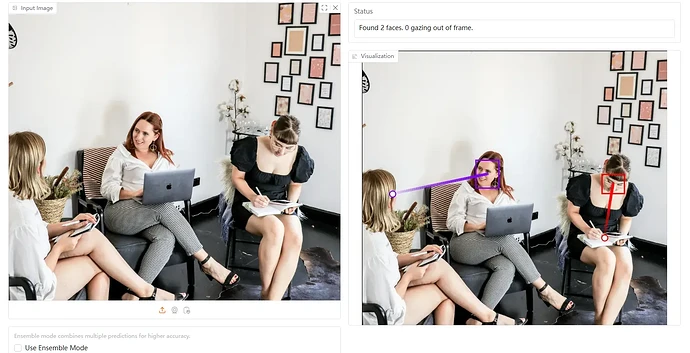

Gazelle 多人注视检测技术在线版本发布,精准检测目光方向

Gazelle 是一个开源的多人注视检测技术,能够精准地检测人们的目光方向和注视对象。

现在,Gazelle 的在线版本已经发布,社区提供了两个不同的演示:gaze-demo 和 Gaze-LLE-demo。

微软开源 phi-4 模型:14B 参数,性能超越 GPT-4o

phi-4 是微软刚刚开源的最强小参数模型,其参数仅为 14B。

在各种基准测试中,phi-4 对比同参数量的模型表现优异,甚至在 GPQA 和 MATH 基准测试中超过了 GPT-4o。这个模型最初于去年 12 月 12 日发布,现在竟然直接开源了,并且基于 MIT 协议,可随意商用。

Adobe 发布 TransPixar:生成透明背景视频的创新技术

player.bilibili.com/player.html?bvid=BV1DzrqYKEdD

TransPixar 是 Adobe 最新发布的一项创新技术,能够通过文本和图像生成透明背景的视频。

不仅支持创建烟雾和反射等透明元素,还提供了高度逼真的视觉效果。可以看看演示视频,效果相当不错。也可以在 Hugging Face 体验在线版本,不过在线版限制了帧率和推理步骤。代码是开源的,有兴趣的可以直接本地部署。

SAI 开源 SPAR3D:一秒内从单图生成可编辑 3D 模型

player.bilibili.com/player.html?bvid=BV1YqrqYBEGb

SPAR3D 是 SAI 最近开源的一项图生 3D 技术,能够在短短一秒内从单张图片生成可编辑的 3D 模型。这项技术对于商业和非商业用途均免费开放,只要年收入小于 100 万美元即可使用。目前,代码和模型都已经公开发布。

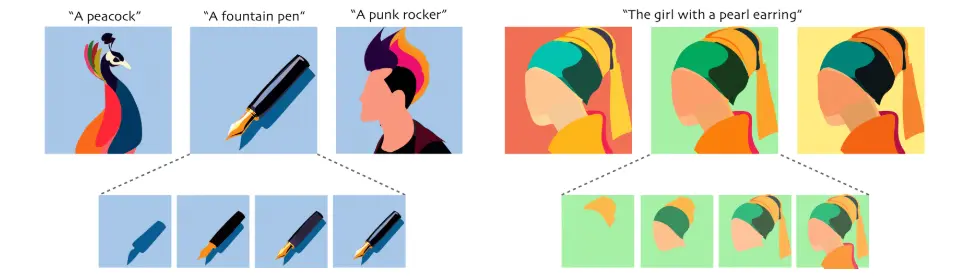

NeuralSVG:文本生成可编辑矢量图形的创新工具

NeuralSVG 是一款创新的工具,能够根据文本提示生成有序且可编辑的矢量图形。通过简化和分层 SVG 输出,NeuralSVG 解决了传统 SVG 生成结构过于复杂、难以二次编辑的问题。

官方展示的效果非常出色,生成的 SVG 文件不仅结构清晰,还支持分层编辑,极大地方便了设计师和开发者。目前,NeuralSVG 尚未开源,但我会持续跟进最新动态,第一时间为大家带来更新。关注我,不错过任何重要信息!