今天在自己的电脑上通过ollama部署了deepseek r1。ollama真是简单易用呀!

但是我的显卡内存太小,只能部署了7b的版本,显存大约6G的样子,不知使用过程中,是不是会越来越大?

群里大侠有本地部署的吗?deepseek r1:7b 模型,聪明程度怎么样?应该模型越大越聪明吧,7b这种小模型能达到gpt3.5的水平不?

另外,我看文档说,ollama默认最大token是4096。 可以设置各大,更大会出现什么状况?会卡死吗?比如设置成128k,会发生什么?

有本地部署的兄弟,分享一下你们的使用情况?谢谢!

7b肯定没有14b、32b、70b聪明啦

默认4096是它能理解并记住的上下文,你就理解成![]() 只有7秒的记忆一样。7秒之后它还是条

只有7秒的记忆一样。7秒之后它还是条![]() 只不过忘记7秒之前它都跟你聊了些什么。

只不过忘记7秒之前它都跟你聊了些什么。

不错啦,我们只能眼馋

14b上下文多少?

好像和4o差不多,可能比4o还强一点

14b是基于qwen2.5-14b为基模蒸馏训练出来的。最大上下文128K

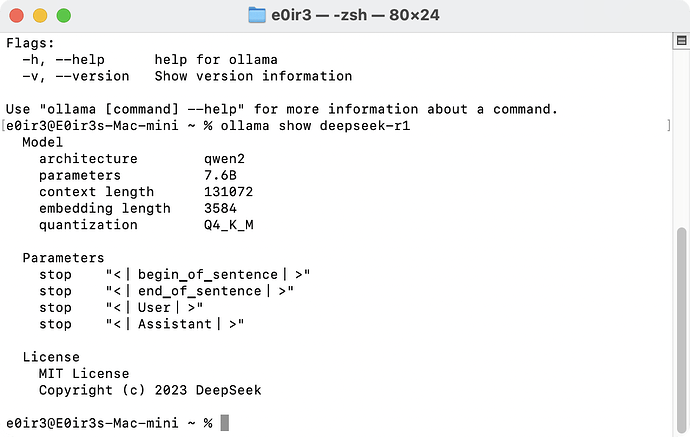

qwen2.context_length 131072

详细参数可以参考下ollama官网

感谢,好像ollama里面有命令可以看

是的。

(base) xx@xxdeMac-mini /workspace % ollama show deepseek-r1:70b

Model

architecture llama

parameters 70.6B

context length 131072

embedding length 8192

quantization Q4_K_M

Parameters

stop "<|begin▁of▁sentence|>"

stop "<|end▁of▁sentence|>"

stop "<|User|>"

stop "<|Assistant|>"

License

MIT License

Copyright (c) 2023 DeepSeek

deepseek-r1:70b 0c1615a8ca32 42 GB

这个4bit量化的版本大概是42GB,可以稳定的运行在64GB内存的m4-mini上

对对就是这个

7b的参数也是这么多。真的可以喂这么多token给它?有人试过吗?

可以喂的,就是考验你的显存大小

我拉个phi4都觉得卡,哎。本地部署算是放弃了

对,M2运算能力是一码事,但是内存8G是硬伤。因为只有8G内存,但是每次推理的时候就要先把4.7GB的模型都加载到内存里,那系统可未必有这么多内存。所以就会启用swap,把原来在内存里的一些数据mv到swap里去,那ssd的速度跟统一内存的速度可就没的比了。

佬可以试试看ollama run deepseek-r1之后,只要完全加载到内存之后,再问答的时候就没有那么慢了。

现在内存便宜,64G不是问题。只要是显存。显存不够呀。显卡太贵了。

想部署个,但现在只缺个显卡了! ![]()

你们都喜欢本地部署吗

我说的是苹果电脑的统一内存没的显卡。显存64g的得拿辆车来换

其实也只是测试,了解AI这个东西。除非是企业呀,否则不说显卡,电费就很贵。不可能24小时开着。企业会寻求本地部署,毕竟需要私有知识库。

还行,勉强能跑个14b