synbio

(Schrödinger)

1

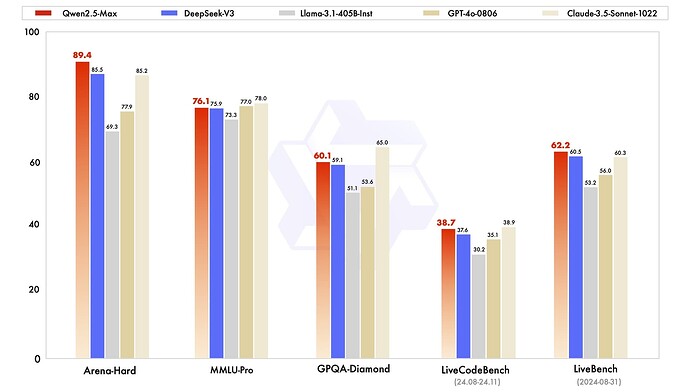

阿里Qwen连夜发布了超大规模MoE模型:Qwen2.5-Max,性能超过了DeepSeek V3

Qwen2.5-Max使用超过20万亿token的预训练数据

在Arena-Hard、LiveBench、LiveCodeBench、GPQA-Diamond测试中,超过了 DeepSeek V3

在基座模型中,Qwen2.5-Max 超过了 DeepSeek V3、Llama-3.1-405B、Qwen2.5-72B

可以Qwen Chat或API中使用,在Qwen Chat中直接与模型对话,或者使用 artifacts、搜索等功能

博客

Demo

10 个赞

l516q

(l516q)

4

千问以前的都是弱智,希望这个真能像说的这么好,最早研究的大厂,到现在拿不出像样的产品,挺丢人

linduda

(linduda)

7

这个是闭源的,估计要等qwen3出来才有像deepseek v3那样的超大MOE模

Yanan

(YANAN)

11

去年年底阿里云天天跟我打电话推销他们的的模型,还给各种优惠什么的,当时我就感觉阿里有点急哈哈

1 个赞

wangbinio

(wangbinio)

15

阿里那个写代码的好像不太行啊,各个地方的评分都不如fitten和codegeex