奇了怪了,后来试了1.5b的,点load也不装载

19 个赞

佬用的什么软件或方法部署的?

内存/显存不够吧。手机上能跑啥?1.5B的都跑不动

都有博主测试啦,7b没问题,我弄1.5都加载不上,手机都是同型号的,我就奇了怪了

1.5b还是行的,7b太慢了

你试验成功了吗?我怎么1.5b的不灵呢?你什么设备?

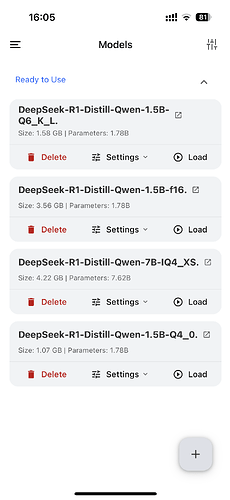

你看我下的那三个模型,一个也不能加载,是怎么回事

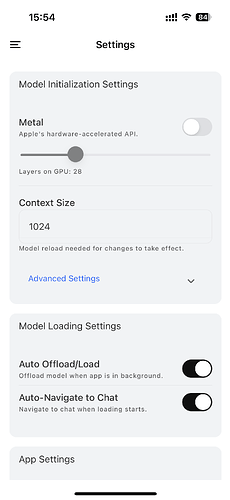

你看看我这个

说实话,这点信息,根本看不出问题在哪

试试这个模型看看能不能运行?

deepseek-r1-distill-qwen-1.5b-q4_0.

benchmark 也可以测试一下

![]()

后台是不是放太多软件啦

我试试再换你说的这个模型

苹果不至于啊,莫非让我清理后台?那每次运行这个AI可就累了,按理说是自动的

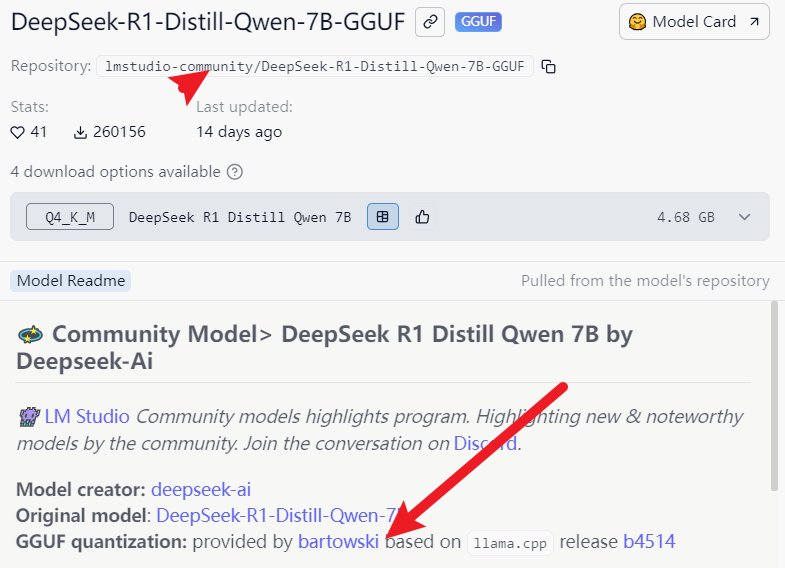

为啥不去读一读HF这三个模型的文档说明,简要来说是制作模型文件GGUF的人不同,分别是bartowski、unsloth,lmstudio-community 三方(其实是两方,社区版直接使用bartowski),模型参数文件基于llama.cpp实现量化,使用的一些方法和数据可能存在某一些差异,模型文件的尺寸、内存占用率、效率等等可能存在一些不同,但是差异微乎其微。

嗯,我大概也知道是三个不同的发布者。我是想问问有经验的人模型差异大不大