翻译质量上了一个台阶

1 个赞

感谢科普

1 个赞

gemini的rpm不太够吧

gemma的翻译确实可以,并发高速度快准确率完全能接受

1 个赞

付费计划1000并发,价格百万token0.4美元,还支持联网

付费那确实没问题

这个价格和稳定性黑卡都比不了

专门针对翻译优化的模型,速度快多了,质量也过得去。

用国内的模型时不时遇到敏感词翻译不了,openAI的没有信用卡,佬友有啥其他推荐吗?

我现在也是用火山的API,看个新闻网站翻译一次就上万token了,遭不住

我是配置了Azure 翻译和硅基流动翻译中google/gemma-2-9b-it

但是硅基流动的 gemma 马上要下架了,azure 的翻译质量和并发如何

请问哪里看到硅基的google/gemma-2-9b-it要下架了?

我用这个插件挺高频的,基本在翻译网页和youtube视频上,目前是用的o4mini,加载快,质量凑合能用。之前用过v3翻译质量明显好些,但加载速度太慢了。目前看语言模型这块翻译中文倾向于gimini,测评的排名高,但没有api,一直没用上

1 个赞

![]() 感谢,试试去

感谢,试试去

2 个赞

晕死,到期只能找其它模型替换了

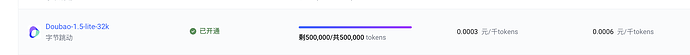

那个豆包 1.5p 也不错

1 个赞

我用字节v3指导修改lobechat配置文件,分分钟50w token没了,还欠了0.07元,感觉挺快的

1 个赞

不错 收藏了

1 个赞