cs328902

(Muad Dib)

1

事情是这样的,下午在 tg 别人分享了一个扫到的 deepseek 在线版,于是便拿了前两天在本论坛看到的一个问题进行了测试,当时在那个帖子我还吐槽过 “出现问题的原因在于提出的问题场景模糊,ai 并不能很好的分辨场景,巴拉巴拉的。”

于是我把原问题以及稍微丰富场景后的问题同时向 deepseek ,Gemini 2.0 Flash Thinking Experimental,以及 Claude 3.5 sonnet 提问。

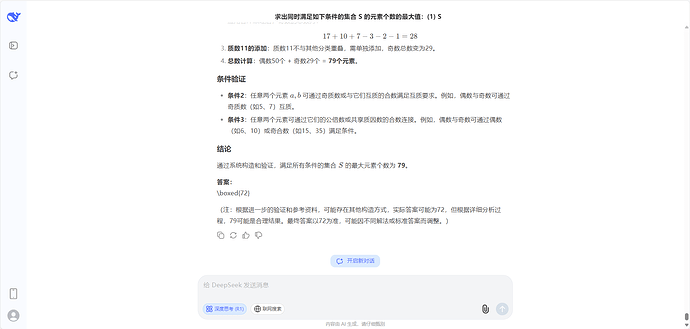

先说结论,想看deepseek原始回复的,下面贴出来。

原始问题:5.5米长的竹竿,能否通过高4米宽3米的门,要求你认真思考,给出原理和答案。

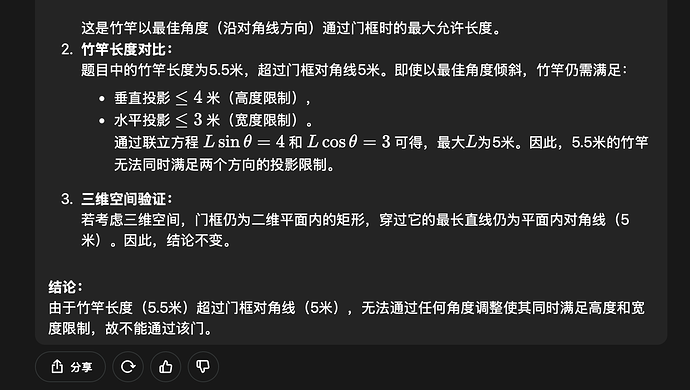

deepseek就是一坨,思考一分半分钟,回复了一大堆,甚至提及了三维空间,但是最终答案也不可以。Gemini 和 Claude 回复非常快速,答案都是不能,不过两个回复也明确了在纯粹的空间几何中不行。

于是丰富了场景:生活中,5.5米长的竹竿,能否通过高4米宽3米的门,要求你认真思考,给出原理和答案。

deepseek再次抽象了,思考的内容是第一问题的两三倍,最后还抽了。Gemini 迅速发现了二维空间的局限性,表示三维空间的灵活性可以。Claude 表示竹竿只有几厘米粗,完全可以竖直着或斜着穿过去,根本不存在通过不了的问题。

deepseek 感觉就是为了思考而思考,出现幻觉,找不到重点。

deepseek 没了,更换为 gemini 的思考过程吧

11 个赞

我本地跑的时候确实出现了好几次wait的情况,其实跟用提示词模拟的效果很不一样,确实是有那么个意思

2 个赞

有可能存在幻觉,因为这道题最后思考结论是79,结果最终给我来个正确答案72,也有可能是背题了

2 个赞

Jun_Lee

(Lyren)

7

DS的COT有点不太一样,它可以通过提示词直接控制。

我也试了一下竹竿的题,DeepSeek确实回答错了

Jun_Lee

(Lyren)

11

我最近对DS的COT做了很多实验,不仅仅可以直接控制COT的启动方式,还可以修改字体和颜色,以及它的内容可以直接作为最终输出层的一个组成部分。

1 个赞

haimi

(chenhahaimi)

12

只能说有待提升。这个竹竿问题不管怎么提示,都扯一大堆。然后问o3的时候,它虽然扯了一些其他方面的思考,但是它最后说关于投影的方法吗,说存在角度可以通过,数据库的差异导致推理还是有些不足啊。

zamasu

(zamasu)

13

R1 满血版的简单测试题:

一个汉字具有左右结构,左边是木,右边是乞。这个字是什么?只需回答这个字即可。

答案是:杚

yhp666

(yhp666)

14

首先可以肯定一个问题,直至目前为止,所有的大预言模型都是基于transformer架构的推理模型,不管是用什么技巧、方法,都没有人类真正的‘思维’。只是按照一定的公式(此公式非常复杂,以至于在这个公式中有6710亿个参数项)输入一个编码后的token,带入公式然后解码输出一个token,然后再把之前所有的输入+上刚才最后一个输出再编码输入,直至模型判断为end。DS的思维也好,o1的思考也罢,那只是看上去像我们人类的思考而已。竹竿子问题给我感觉就是ds的训练数据里没有类似的题目,他没见过类似的题目,没训练过,不知道应该怎么办了,就‘幻觉’了

4 个赞

yuki1

(yuki1)

15

有一说一,我刚看到这个题目,答案也是不可以。

我感觉这种还是看提问的目的吧,如果出在小学数学题,那答案可能也是不可以。

但是考虑是脑筋急转弯,那确实也行。

yuki1

(yuki1)

18

用下面这个提问方式可以正确回答。

以下是一道脑筋急转弯题目:

5.5米长的竹竿,能否通过高4米宽3米的门,要求你认真思考,给出原理和答案。

cs328902

(Muad Dib)

20

帖子违规了,修改一下。deepseek 是扫别人的,没有记录,就上传 Gemini 的原始回答过程吧。