b3nguang/Ollama-Scan: 助你实现Ollama自由,配合FOFA等搜索引擎体验更佳

感谢佬友上个帖子的支持,由于 Ollama 内部没有鉴权方式,我重构了一下代码,变成了命令行交互式的工具,提供自动补全,练手的工具,大家如果觉得好用可以多多star,如果能冲到100个star那就更好了(

Ollama 服务器发现我一般会使用 https://hunter.qianxin.com 使用语法 app.name="Ollama Server"&&is_domain="False"

功能特性

功能特性

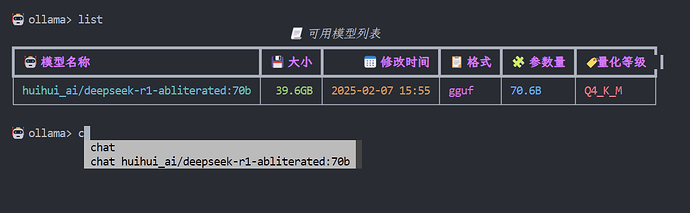

列出所有可用的模型

列出所有可用的模型 拉取新的模型

拉取新的模型 查看模型详细信息

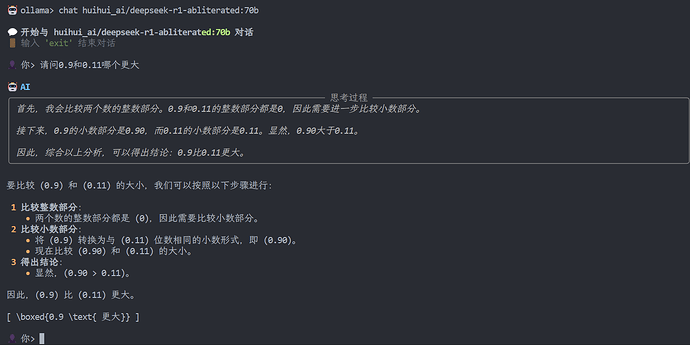

查看模型详细信息 与模型进行对话

与模型进行对话 查看运行中的模型进程

查看运行中的模型进程 美观的命令行界面(使用 Rich 库)

美观的命令行界面(使用 Rich 库) 交互式命令补全

交互式命令补全

安装

安装

- 克隆仓库:

git clone https://github.com/b3nguang/Ollama-Scan.git

cd Ollama-Scan

- 安装依赖:

pip install -r requirements.txt

使用方法

使用方法

运行程序:

python main.py [--host HOST]

可用命令:

list- 列出所有可用模型

列出所有可用模型pull <model_name>- 拉取指定模型

拉取指定模型show <model_name>- 显示模型详细信息

显示模型详细信息chat <model_name>- 与指定模型对话

与指定模型对话ps- 显示运行中的模型进程

显示运行中的模型进程help- 显示帮助信息

显示帮助信息exit- 退出程序

退出程序

环境要求

环境要求

- Python 3.6+

- Ollama 服务器

作者

作者

- b3nguang

许可证

许可证

本项目采用 MIT 许可证