1 个赞

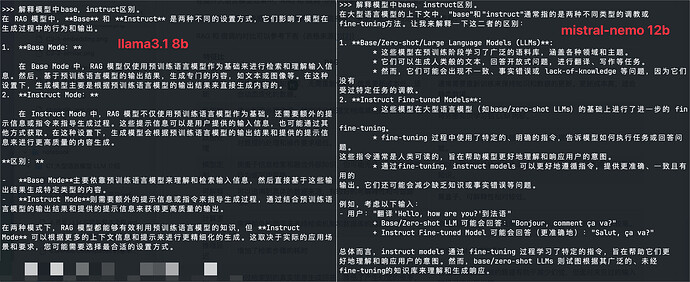

带Instruct的模型经过指令微调,专注于多语言对话和特定任务,能够更好地理解和响应用户指令,输出多语言文本和代码。相较之下,不带Instruct的模型则更通用,适用于广泛的文本生成任务,但在特定指令响应上表现较弱

2 个赞

OK,谢谢!

1 个赞

不就是可不可指令调试啊。

佬请问这个模型在哪里下载,hugging face上我申请后被拒了

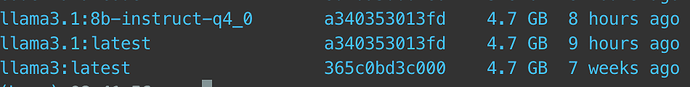

可以去 ollama 上下载 llama3.1

1 个赞

好的,谢谢

instruct的调过了

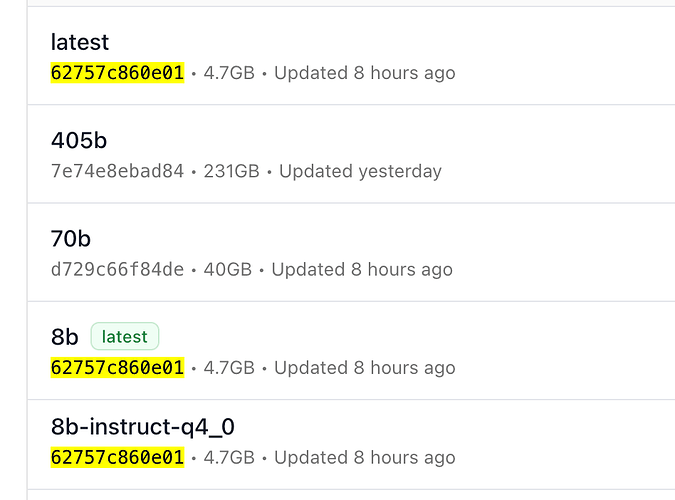

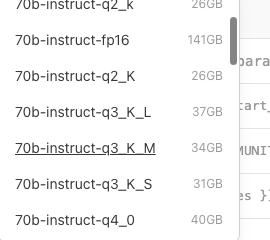

instruct 在ollama上有很多版本,有佬友知道都是什么意思么?

不是一样的。一般对话 LLM 需要通过预训练、指令微调、强化学习(偏好对齐)这三个训练阶段,具体可以 Google 详细了解。这里非 Instruct 是只经过预训练的模型,Instruct 是经过完整三个阶段的模型,一般用户选择 Instruct 就好了。

提供 Base 模型主要是满足开发者根据具体下游任务微调等需求。

1 个赞

那是量化等级,量化可以降低模型的显存或存储占用,但激进的量化会损伤模型质量,一般情况建议选择 Q4 以上量化。至于 Q4KM IQ4XS 这些前后缀和具体量化算法有关,有兴趣可以阅读 llama.cpp 的 PR 了解,总的来说就是试图在显存和质量上取得平衡。

一般情况,选择的话选你的设备显存或者内存最大能装下的即可。

1 个赞

说明ollama默认下的就是微调的

没那么复杂 理解成有instruct的是专门对话的 其他的是文本生成的就行 chat同理 后面那些都是量化优化的标签 具体自己看这个 k-quants by ikawrakow · Pull Request #1684 · ggerganov/llama.cpp · GitHub

1 个赞

一个带鸡蛋一个不带

From #develop:ai to 资源荟萃