F-droid

2024 年10 月 17 日 14:49

1

今天打开 Hugging Face打算部署项目时,意外发现了一个新功能:现在可以直接通过 Ollama 跑 Hugging Face Hub 上的 GGUF 模型!

当时点进去看了一下,第一眼感觉就和 Docker Hub很像,整个流程非常简洁,就像是 Hugging Face Hub 成为了 Ollama 的第三方镜像源一样,直接拉取模型就能跑。根据官方的介绍,只需要一个简单的命令就可以运行 GGUF 模型,非常方便:

ollama run hf.co/{username}/{repository}

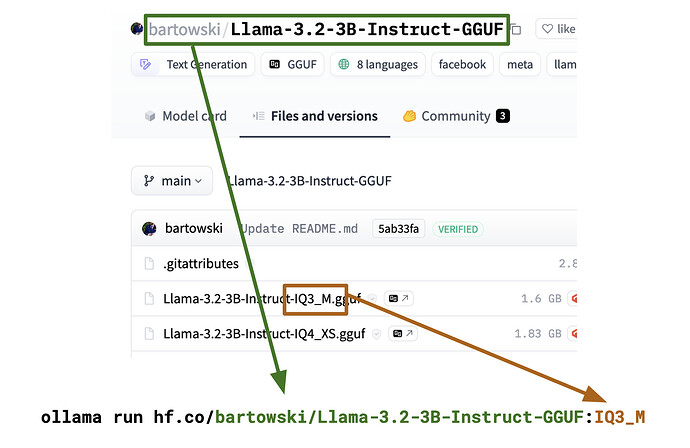

目前 Hugging Face Hub 上已经有 45K 多个公开的 GGUF 检查点可以用 Ollama 直接运行,还支持自定义量化类型和聊天模板,功能非常强大。对于需要本地跑 LLM 模型的开发者来说,这无疑是个好消息。

感觉 Hugging Face真的是越来越强大了,除了训练模型、管理数据,现在连本地部署都这么方便了。

给大家分享几个可以试试的模型:

ollama run hf.co/bartowski/Llama-3.2-1B-Instruct-GGUF

ollama run hf.co/mlabonne/Meta-Llama-3.1-8B-Instruct-abliterated-GGUF

ollama run hf.co/arcee-ai/SuperNova-Medius-GGUF

ollama run hf.co/bartowski/Humanish-LLama3-8B-Instruct-GGUF

如果你也在用 Ollama,或者对 Hugging Face Hub 感兴趣,赶紧试试这个新功能吧!

使用Ollama的佬友门,你肯定在用Open Webui吧!这里我就贴一个适合Open Webui的ChatGPT O1提示词给大家分享一下。

79 个赞

lingo

2024 年10 月 17 日 15:33

5

有点牛逼,朋友。以后跑 theDrummer 再也不用写Modelfile了

1 个赞

F-droid

2024 年10 月 17 日 15:34

6

看来这样的时代要一去不复返了!我主要还想看看Open Webui这边会有什么动作

挺好的 唯一的槽点就是默认ollama可以国内直连pull,这个走的hf官方 得代理

2 个赞

F-droid

2024 年10 月 17 日 16:14

8

把之前代理dockerhub的CF workers脚本直接拿过来修改一下就可以用,看看哪家封号的概率低活的长久,就用哪家版本的了,走hf官方可以拉取的镜像就更多了。

1 个赞

gyssi

2024 年10 月 17 日 16:21

9

你的ip地理位置 我在服务器上部署了 效果不错,防止滥用我要加个token 是不是修改py代码就可以啊?

源码我看你预留了

1 个赞

F-droid

2024 年10 月 17 日 16:24

11

gyssi:

要加个token

我感觉意义不是很大,反正这都是别人的服务器,又不心疼,而且公开仓库不就是让更多的人能够用嘛!

1 个赞

ProxyCN

2024 年10 月 18 日 03:04

16

openwebui卡的一批,点击外部链接要等很久很久。

F-droid

2024 年10 月 18 日 18:02

17

长时间不重启就是这样的,各种占用是直线上升。我是白嫖的抱抱脸空间,每天docker都自动构建一次并重启,自动同步上游代码更新,全靠GitHub Action来自动完成,我既不会遇到卡顿,又不需要手动更新!

hsyg63m5

2024 年10 月 18 日 19:43

18

我理解错了 还以为能在hugging face直接跑自定义开源模型

1 个赞

F-droid

2024 年10 月 20 日 01:18

19

这个不是直接跑啊,类似于docker那样的,直接的你也可以去申请一个token,然后直接调用抱抱脸的模型,论坛里有佬友发过

1 个赞

![]()