谁不想拥有一只自己的小羊驼呢 ![]()

30秒跑起来!精简版

windows电脑!https://ollama.com 下载,安装

cmd运行ollama run qwen:14b

开始对话!

A.开始准备

-

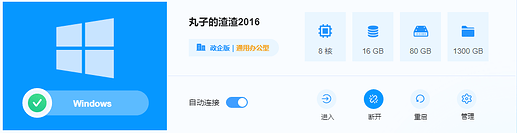

一台windows电脑(我的:8核16G云渣渣机,配置越高跑的越好;注:无GPU也是可以跑的!)

-

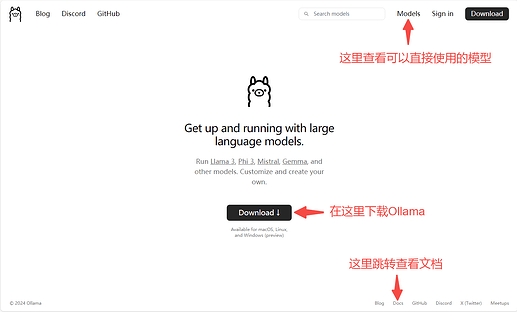

一个Ollama安装包,网址:https://ollama.com (进官网直接下载windows版本即可)

B.安装运行

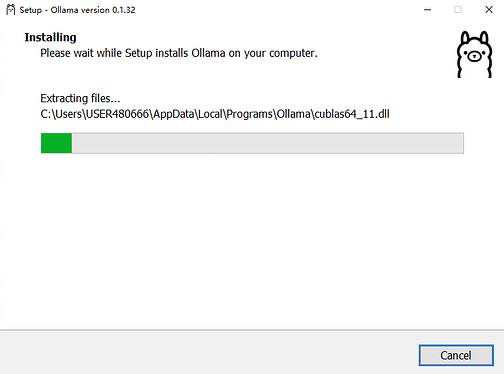

- 1. 打开刚刚下载的Ollama安装包,直接Install!

(它会默认安装在C:\Users{你的电脑账户名}\AppData\Local\Programs\Ollama)

-

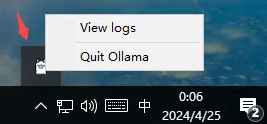

2. 没错,直接完成,这时你可以在你的电脑任务栏右下角发现小羊驼。

(当前,你还可以在你的开始菜单中找到它)

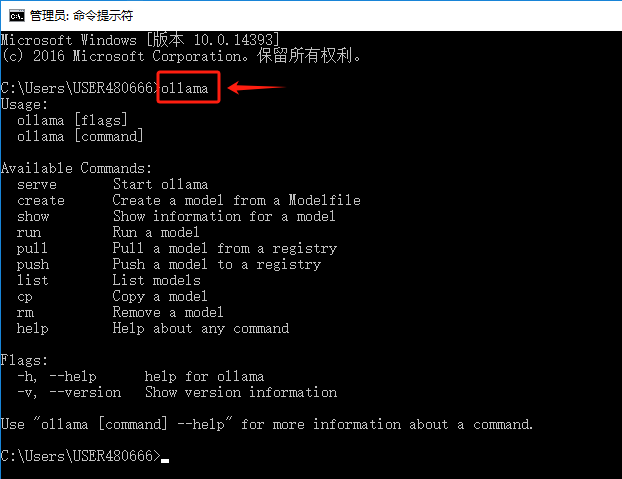

没问题的话,你现在可以进入CMD,使用ollama命令了!

-

3. 尝试使用

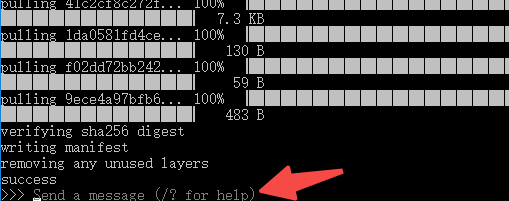

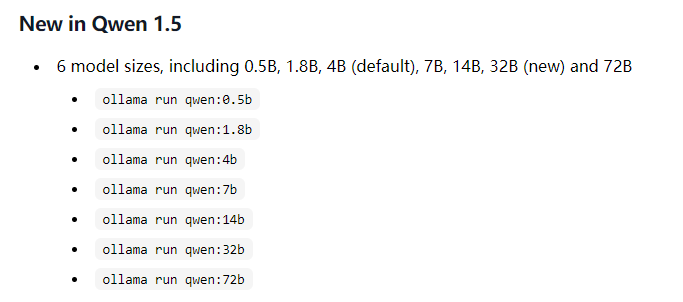

ollama run qwen:1.8b跑一下千问1.8b模型吧~

(他会自动下载,然后自动运行,没错,全自动,只要你把模型输入正确,如果你电脑还不错可以试一下qwen:14b或者更高)看到Send a massage,完成!开始享用吧,直接打字回车对话!

效果:

C.可能遇到的问题

-

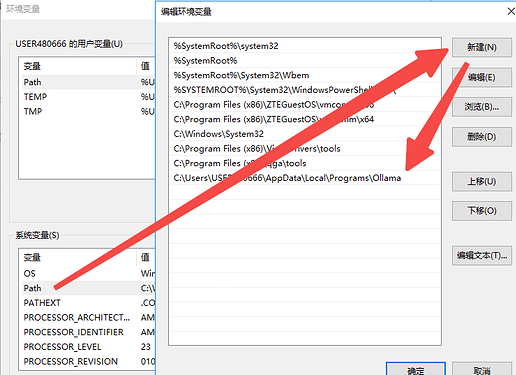

1. ollama命令无法使用?

控制面板 → 搜:高级系统设置 → 环境变量 → Path – >新建

C:\Users\{你的电脑账户名}\AppData\Local\Programs\Ollama

-

2. 可以run的模型在哪找?

这里:library 每个模型打开下面都有介绍!

-

3.如何查看我的GPU是否支持?

请前往查看 ,N卡、A卡都可以的:

,N卡、A卡都可以的:

ollama/docs/gpu.md at main · ollama/ollama · GitHub -

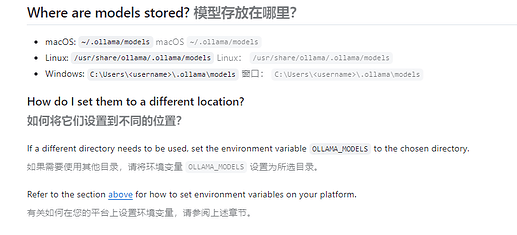

4.模型的存放位置能改吗,我C盘存不下!

可以,请设置环境变量OLLAMA_MODELS

下集预告:[ 7分钟,让你的Ollama本地大模型拥有UI - OpenWebUI【小白向】 ]