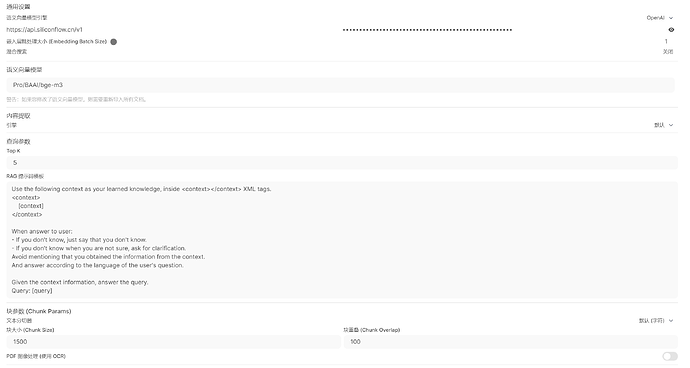

我自己备了gpt、gemini和claude的api接口,平常聊天用的都没问题,但是传pdf的时候,问完问题后的回答都好简短,感觉就跟它没怎么看文件似的,跟这几个模型的网页版体验比不了,所以我一般有让大模型读文档的需求的话,都是用国内的通义千问和Kimi这些。我也在openwebui里设置了向量模型这些,但是我不太明白这些。所以不知道是我设置的问题,还是向量模型不够好,亦或是openwebui本身的rag就一般。或者说,有没有上传/解析文件能和官网差不多体验水平的api转接UI呀?

1 个赞

关注一下,段一波后续

pdf好多都是图片,获取不到实际性内容,分析个代码片段之类的文本还是没问题的。