现状:在服务器部署了一个Open WebUI,然后在Mac本机上用ollama安装了几个模型

尝试:网上的教程都是Mac本机再装一套docker部署一套Open WebUI,搜索了一圈木有服务端-本机分开的这种类似场景

问题:想请教各位大佬,有什么方法可以配置打开服务器上的页面,但是后端可以自动读取用户访问这一段本机的模型吗?

9 个赞

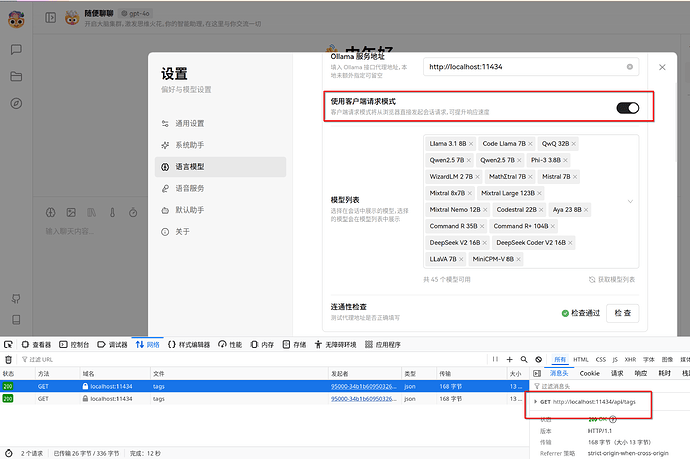

假设你的服务器ip为192.168.1.1,你的本机地址是192.168.1.9,并且你在服务器中安装了open webui(端口为3000),在本机安装了ollama(端口保持默认11434),则:

Step 1 打开Open webui:http://192.168.1.1:3000, 使用管理员身份(第一个注册用户)登录

Step 2 在Open webui界面中,依次点击“展开左侧栏”(左上角三道杠)–>“头像”(左下角)–>管理员面板–>设置(上侧)–>外部连接

Step 3 在外部连接的Ollama API一栏将switch开关打开,在栏中填上“http://192.168.1.9:11434”

或点击栏右侧的“+”添加一个API地址,并将你的地址填上

Step 4 点击右下角“保存”按钮

Step 5 点击“新对话”(左上角),确定是否正确刷出模型列表,如果正确刷出,则设置完毕。如果未刷出,则请确认ollama已“允许局域网或外部访问”

多谢大佬解答~

有点尴尬的是,服务器是公网的,本机是不是只能内网穿透暴露出IP才行了

服务器如果是自己的就好办,如果是云上的就得内网穿透了。