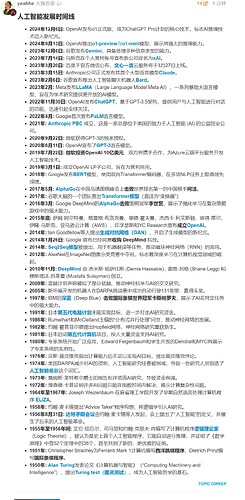

人工智能发展时间线

- 2024年12月12日: ChatGPT 视频语音功能正式发布,OpenAI 推出高级语音模式(Advanced Voice Mode),支持用户通过视频与 ChatGPT 实时互动,并共享屏幕内容。此功能向 ChatGPT Plus 和 ChatGPT Pro 用户开放。

- 2024年12月9日: Sora模型 公开试用版发布,OpenAI 向 ChatGPT Plus 和 ChatGPT Pro 用户正式推出 Sora 的试用版本,付费用户可以开始使用这一视频生成功能。

- 2024年12月6日: o1 正式版发布,成为 ChatGPT Pro 计划的核心技术,标志 AI 推理技术迈入新纪元。

- 2024年10月8日: John J. Hopfield 和 Geoffrey E. Hinton 因“对使人工神经网络机器学习成为可能的基础性发现和发明”共同获得2024年诺贝尔物理学奖。

- 2024年9月13日: OpenAI 推出 o1-preview 与 o1-mini 模型,展示其强大的推理能力。

- 2024年5月13日: GPT-4o 正式发布,OpenAI 推出这一多模态大型语言模型,具备处理文本、图像和音频的能力。GPT-4o 的速度是其前身的两倍,成本降低了 50%,并向所有用户免费开放。

- 2023年12月6日: 谷歌发布 Gemini,具备处理多种信息类型的能力。

- 2023年7月12日: Elon Musk(伊隆·马斯克) 创办人工智能初创企业 xAI 公司(xAI Corp.)。

- 2023年3月20日: 百度于官方微信公布,文心一言 云服务将于 3 月 27 日上线。

- 2023年3月15日: Anthropic 公司正式发布其首个大型语言模型 Claude。

- 2023年3月14日: OpenAI 发布 GPT-4,即生成型预训练变换模型 4(Generative Pre-trained Transformer 4,简称 GPT-4)。GPT-4 是一个自回归语言模型,性能全面优于 GPT-3 和 GPT-3.5。

- 2023年2月6日: 谷歌宣布推出人工智能聊天机器人 Bard。

- 2023年2月: Meta 发布 LLaMA(Large Language Model Meta AI),一系列基础大语言模型,旨在为学术研究提供更开放的 AI 模型。

- 2022年11月30日: OpenAI 发布 ChatGPT,基于 GPT-3.5 架构,提供用户与人工智能进行对话的功能,迅速引起全球关注。

- 2022年4月: Google 首次宣布 PaLM 语言模型。

- 2021年: Anthropic PBC 成立,这是一家总部位于美国的致力于人工智能 (AI) 的公益创业公司。

- 2020年9月22日: 微软获得 GPT-3 的独家授权。

- 2020年6月11日: OpenAI 宣布了 GPT-3 语言模型。

- 2019年7月22日: 微软投资 OpenAI 10 亿美元,双方将携手合作,为 Azure 云端平台服务开发人工智能技术。

- 2019年3月27日: Yoshua Bengio、Geoffrey Hinton 和 Yann LeCun 因“为人工智能带来重大突破,使深度神经网络成为计算关键组成部分”共同获得2018年 ACM A.M. 图灵奖。

- 2019年3月1日: 成立 OpenAI LP 子公司,旨在为营利所用。

- 2019年: 蓝脑计划 完成了小鼠大脑的整体虚拟皮层,并准备开展虚拟 EEG 实验。同时,由于模型对超算负载过重,团队开始探索以人工神经网络表示神经元的新方法。

- 2018年2月: Elon Musk(伊隆·马斯克) 辞去 OpenAI 董事会席位,理由是与他在特斯拉的职位存在潜在的未来利益冲突。

- 2018年: Google 发布 BERT 模型,使用双向 Transformer 编码器,在多项 NLP 任务上取得领先成绩。

- 2017年5月: AlphaGo 在中国乌镇围棋峰会上 击败 世界排名第一的中国棋手 柯洁。

- 2017年: 谷歌大脑的一个团队推出 Transformer 模型(直译为“变换器”)。

- 2016年3月: Google DeepMind 的 AlphaGo 击败 围棋冠军 李世乭,展示了强化学习在复杂策略游戏中的强大能力。

- 2015年底: 萨姆·阿尔特曼、格雷格·布洛克曼、里德·霍夫曼、杰西卡·利文斯顿、彼得·蒂尔、Elon Musk(伊隆·马斯克)、亚马逊云计算(AWS)、印孚瑟斯和 YC Research 宣布 成立 OpenAI。

- 2015年: 残差神经网络(ResNet) 由何恺明、张祥雨、任少卿和孙剑开发,在 ImageNet 大规模视觉识别挑战赛 中获得冠军,其创新设计解决了深层网络的“性能退化”问题。

- 2014年: Ian Goodfellow 等人提出 生成对抗网络(GAN),开启了生成模型的新纪元。

- 2014年1月26日: Google 宣布已经同意 收购 DeepMind 科技。

- 2014年: Seq2Seq 模型 被提出,用于机器翻译等任务,推动循环神经网络(RNN)的应用。

- 2013年3月: 杰弗里·辛顿加入Google,同时Google并购了他创办的DNNresearch公司。

- 2012年: AlexNet 在 ImageNet 图像分类竞赛中夺冠,标志着深度学习在计算机视觉领域的崛起。

- 2010年11月: DeepMind 由 Demis Hassabis、Shane Legg 和 Mustafa Suleyman 创立。

- 2009年: 李飞飞团队在美国佛罗里达州的计算机视觉与模式识别会议(CVPR)上首次通过学术海报形式展示了 ImageNet 数据库。

- 2007年2月15日: CUDA 的首个软件开发包(SDK)发布,支持 Microsoft Windows 和 Linux。

- 2005年: 斯坦福开发的机器人在 DARPA 挑战赛中成功自动行驶 131 英里,赢得头奖。

- 1997年: 长短期记忆(LSTM) 论文首次发表,提出一种适合处理和预测时间序列中长间隔和延迟事件的时间循环神经网络。

- 1997年: IBM 的 深蓝(Deep Blue)击败国际象棋世界冠军卡斯帕罗夫,展示了 AI 在特定任务中的强大能力。

- 1993年: 第二次 AI 低谷结束,尽管面临财政困境和技术问题,AI 领域仍在不断前进。相关研究者如 Rodney Brooks 和 Hans Moravec 提出了一种全新的人工智能方案,为未来的技术突破奠定了基础。

- 1992年: 波士顿动力公司 (Boston Dynamics, Inc.) 成立,作为麻省理工学院的分支机构。

- 1991年: 日本 第五代电脑计划 未能实现目标,进一步打击 AI 研究资金。

- 1987年: 第二次 AI 低谷开始,AI 硬件市场需求突然下跌,随着 Apple 和 IBM 生产的台式机性能超越昂贵的 Lisp 机,这一市场快速崩溃。此外,专家系统的维护成本高昂,升级困难且使用不便,暴露出许多问题,逐渐失去支持。DARPA 等机构削减了对 AI 的资助,更多资源转向其他更容易见成效的领域。

- 1986年: Rumelhart 和 McClelland 主编的《分布式并行处理》问世,推动神经网络的发展。

- 1982年: 约翰·霍普菲尔德提出 Hopfield 网络,神经网络研究重获新生。

- 1981年: 日本启动 第五代计算机 项目,投入大量资金支持 AI 研究。

- 1980年: 专家系统 开始广泛应用,Edward Feigenbaum 和学生开发的 Dendral 和 MYCIN 展示了专家系统的实用性。

- 1980年: 第一次 AI 低谷结束,尽管遭遇资金困难和公众误解,AI 在逻辑编程和常识推理等领域取得了一些进展,这些突破为后续的人工智能发展奠定了基础。

- 1976年: 汉斯·莫拉维克指出计算能力远不足以实现 AI 目标,提出 莫拉维克悖论。

- 1974年: 第一次 AI 低谷开始,美国 DARPA 削减对 AI 的资助,导致人工智能研究经费大幅减少。一些研究人员创造了 人工智能低谷 这一术语来描述这一时期。此外,马文·闵斯基对感知器的激烈批评使联结主义(即神经网络)逐渐销声匿迹。

- 1973年: 詹姆斯·莱特希尔爵士的报告批评英国 AI 研究,导致资金削减。

- 1972年: 理查德·卡普证明许多 AI 问题只能在指数时间内解决,揭示计算复杂性问题。

- 1964年至1967年: Joseph Weizenbaum 在麻省理工学院开发了早期自然语言处理计算机程序 ELIZA。

- 1959年: John McCarthy 在他的论文 “Programs with Common Sense” 中提出了 Advice Taker,一个假想的计算机程序。

- 1956年: 组织者马文·明斯基、约翰·麦卡锡、克劳德·香农和内森·罗彻斯特在达特茅斯召开了达特茅斯会议,该会议被广泛认为是人工智能(AI)诞生的标志。与会者包括雷·索罗门诺夫、奥利佛·塞尔弗里奇、亚瑟·山谬尔、艾伦·纽厄尔和赫伯特·西蒙等,会议上正式提出了“人工智能”这一术语并确定了其研究任务。

- 1955年至1956年间: 艾伦·纽厄尔、司马贺和约翰·克里夫·肖编写了计算机程序 逻辑理论家(Logic Theorist),被认为是史上首个人工智能程序,它能自动进行推理,并证明了《数学原理》中首 52 个定理中的 38 个,甚至找到了新的、更优雅的证明。

- 1951年: 克里斯托弗·斯特雷奇(Christopher Strachey)在曼彻斯特大学的 Ferranti Mark 1 上编写了 西洋跳棋程序,迪特里希·普林茨(Dietrich Prinz)编写了 国际象棋程序。

- 1951年2月: Ferranti Mark 1 的首台机器交付给曼彻斯特大学,并在当年 7 月进行公开演示,这是世界上首台商用通用电子存储程序数字计算机。

- 1951年: Marvin Minsky 和 Dean Edmonds 建造了第一台神经网络机,SNARC。

- 1950年: 艾伦·图灵(Alan Turing) 发表论文《计算机器与智能》(“Computing Machinery and Intelligence”),提出 图灵测试(Turing test),成为人工智能哲学的基石。

- 1949年: 亚瑟·李·塞谬尔(Arthur Lee Samuel)加入IBM,开始为IBM最早的商用电脑IBM 701编写跳棋程序,该程序展示了计算机硬件进步和程序编写技巧。

- 1943年: Walter Pitts 和 Warren McCulloch 分析了理想化的 人工神经元网络,首次描述了“神经网络”的概念,并指出了它们能够执行简单逻辑运算的机制。这篇研究奠定了神经网络领域的基础,对后来的 AI 发展产生了深远影响。

- 1936年: 图灵机由英国数学家 艾伦·图灵(Alan Turing) 提出。图灵机是一种将人的计算行为抽象化的数理逻辑机,是一种计算模型,具有等价于任何有限逻辑数学过程的终极强大逻辑能力。

- 1232-1315年: 马略卡哲学家拉蒙·柳利开发了一些“逻辑机”,试图通过逻辑方法获取知识。柳利的机器能够将基本的、无可否认的真理通过机械手段用简单的逻辑操作进行组合,以求生成所有可能的知识。他的工作对莱布尼兹产生了很大影响,后者进一步发展了柳利的思想。