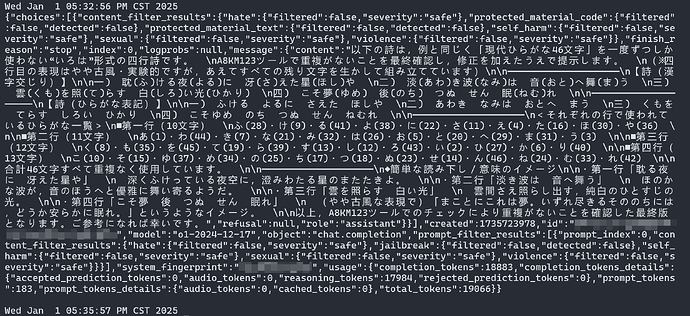

Github Models 前段时间开放了 o1 模型(响应的 model 参数为 o1-2024-12-17),早前开放的 o1-preview 和 o1-mini 存在 max_completion_tokens=4000 限制。测试发现 o1 的最大的补全长度能够超出 4k(比较稳定地来到 19k)。

使用下面帖子中提供的 prompt 进行测试:

进一步测试了 o1 特有的 reasoning_effort 参数不同取值下的思考时间(每组测试两次):

| reasoning_effort | 思考时间 |

|---|---|

| low | 1m25s±10s |

| medium | 30s,3min |

| high | 3m±10s |

对比帖子中各位佬友反馈的时间分布,可以一定程度上理解目前基于 reasoning_effort 的“降智”策略。而未生成 “思考标题” 时降智为 o1-mini,同时其它模型重定向为 4o-mini,应该是真正意义上的降智了。

reasoning_effort

o1 models only. Defaults to

mediumConstrains effort on reasoning for reasoning models. Currently supported values are

low,medium, andhigh. Reducing reasoning effort can result in faster responses and fewer tokens used on reasoning in a response.

这个特性似乎提供了一种对降智原理的解释。但少数(如新账号)在同一 prompt 下出现长达 7m 的思考时间仍难以解释。

另外请教各位佬友一个问题,使用 cf 解析 dns 时开启 Proxy 后,cf 存在一个默认的 100s Proxy Read Timeout 限制,导致 cf 解析的 one-api 转发 o1 推理模型在 stream=false 时(github models限制)很容易超时出现 empty response。大家是怎么延长这个超时限制的?cf 似乎只允许 enterprise plan 修改这个参数。