[开源日报 | Qwen-VL 大模型全面降价;华为轮值董事长孟晚舟新年致辞;“技术债务就像是幸存者的战斗伤痕”;国产 AI 舞台站满了 “90 后天才”]

# 2024.12.31

今日要闻

IBM 计划收购 HashiCorp,遭英国反垄断监管机构审查

据 TechCrunch 报道,英国反垄断监督机构竞争与市场管理局(CMA)已开始调查 IBM 计划收购云软件厂商 HashiCorp 是否会影响竞争。

CMA 周一表示,它将在 1 月 16 日前邀请有关各方就这一并购发表评论。该监管机构暂定 2 月 25 日为最后期限,以决定是批准该交易还是将其提交进一步审查。

IBM 于今年 4 月宣布同意以约 64 亿美元的价格收购 HashiCorp。如果收购继续进行,将扩大 IBM 在云计算和人工智能领域的推进力度,并让该公司获得 HashiCorp 约 4400 家客户的名册。

CMA 于 8 月通知 HashiCorp 将对合并进行审查。美国联邦贸易委员会也在调查这一交易。

阿里云再度降价:Qwen-VL 大模型全面降价

阿里云今天宣布,Qwen-VL 大模型全面降价。这是阿里云本年度的第三轮降价。

Qwen-VL-Plus 模型价格直降 81%,输入价格仅为 0.0015 元 / 千 tokens,创下全网最低价格;而更高性能的 Qwen-VL-Max 降价至 0.003 元 / 千 tokens,降幅达到 85%。根据新的定价,1 元钱可以最多处理大约 600 张 720P 图片,或者 1700 张 480P 图片。

Qwen-VL 系列大模型是阿里云推出的多模态大模型,已成为开源社区最受欢迎的模型之一,具备强大的视觉推理能力。该模型不仅能够识别不同分辨率和长宽比的图片,还能理解 20 分钟以上的长视频,并具备自主操作手机和机器人等智能体的视觉理解能力。

智谱深度推理模型 GLM-Zero 预览版上线

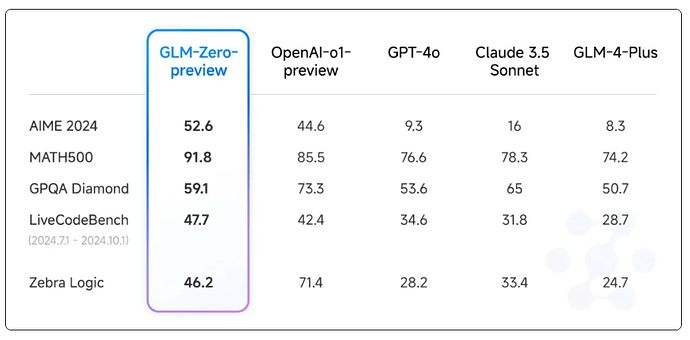

智谱宣布发布本年度最后一个模型 GLM-Zero 的初代版本 GLM-Zero-Preview,这是智谱首个基于扩展强化学习技术训练的推理模型。

根据介绍,GLM-Zero-Preview 是 GLM 家族中专注于增强 AI 推理能力的模型,擅长处理数理逻辑、代码和需要深度推理的复杂问题。同基座模型相比,GLM-Zero-Preview 在不显著降低通用任务能力的情况下,在专家任务能力方面的表现大幅提升,其在 AIME 2024、MATH500 和 LiveCodeBench 评测中,效果与 OpenAI o1-preview 相当。

模型表现如下:

Altman 公布 OpenAI 2025 年将发布的技术产品

OpenAI 首席执行官萨姆・奥特曼(Sam Altman)发帖公布了该公司 2025 年即将发布的技术产品,分别是:

- AGI(通用人工智能)

- Agents(智能体)

- 更好的 GPT-4o 升级版

- 更好的记忆存储

- 更长的上下文窗口

- “Grow up mode”(成人模式)

- 深度研究特色功能

- 更好的 Sora 以及更好的个性化定制

华为轮值董事长孟晚舟新年致辞:2024 年是原生鸿蒙关键一年,一年走过其它操作系统十多年发展之路

据华为官网显示,华为轮值董事长孟晚舟今日发布新年致辞,对客户、生态伙伴、产业链伙伴、员工和家属等表达了感谢。

她在致辞中提到,在万物智联的赛道上,2024 年是原生鸿蒙的关键一年,鸿蒙生态建设千帆起航。鸿蒙千帆计划得到了众多行业伙伴的积极响应,短短一年时间,我们就走过其它操作系统十多年的发展之路,创造了 “鸿蒙速度”。

今日观察

社交观察

“全球互联网上中文内容比例很低” 是一个误读

有人用图一来说明全球互联网上中文内容比例很低,只占 1.4%,实际上这是一个误读。我以前说过一次,这个数据统计方法并不是计算文字量或者网页数量,而是计算使用某种语言的网站数量。

举个例子,微博网站在这个统计中,只能将样本数字 + 1,别管微博上边有多少中文内容,在这个统计方法中,微博跟万年没人看的某些个人站没有区别,都只算一个网站。同样是 W3Techs 提供的数据,图二就很能解释这个问题,只是中文网站数量少,并不是中文内容少。

- 微博 BugOS 技术组

一个大模型需要多大 GPU 内存才能跑起来的计算公式

一个大模型需要多大 GPU 内存才能跑起来的计算公式: M = ((P * 4B) / (32 / Q) ) * 1.2

M: 所需的 GPU 显存,单位是 GB。

P: 模型的参数数量。例如,7B 模型有 70 亿个参数。

4B: 每个参数占用的字节数,这里假设每个参数占用 4 个字节(通常指 FP32 或 Float32 格式)。

32: 4 个字节等于 32 位。

Q: 加载模型时使用的位数。例如,16 位 (FP16/BF16),8 位 (INT8) 或 4 位 (INT4)。这通常称为量化。

1.2: 表示额外开销的系数,通常为 20%。这考虑了除了模型权重之外还需要加载到 GPU 显存中的其他数据,例如优化器状态、梯度等。

如使用 FP16 量化加载 Llama 70B 模型,计算过程就是

M = ( (70,000,000,000 * 4) / (32 / 16) )* 1.2 = 168 GB

- 微博 蚁工厂

大模型导航资源

分享个大模型导航资源,里面收集了几乎全部的模型,具有里程碑意义的论文,排行榜,测试集,训练框架,部署,应用,书籍等

- 微博 karminski - 牙医

英伟达虽然欠下来了大量的 “技术债务”,但在他看来 “技术债务就像是幸存者的战斗伤痕。”

关于先做个垃圾出来,读《英伟达之芯》又看到了一个好例子:

3dfx 破产之后,一个加入英伟达的员工被英伟达的代码库震惊到了,“简直就像是癌症”“代码写得一塌糊涂,开发工具链也是一团乱麻,最重要的是,他们对此毫不在意”“他们一心只想着下一块芯片流片,其他什么都不顾。”

而之前 3dfx 的工作方式则是追求完美,他在那里写出的程序优雅,开发的系统条理清晰、注释详尽,但结果却是一败涂地。

他给的总结相当精辟,英伟达虽然欠下来了大量的 “技术债务”,但在他看来 “技术债务就像是幸存者的战斗伤痕。”

- 微博 i 陆三金

媒体观察

AI 发展:训练数据即将遭遇瓶颈

训练数据即将遭遇的瓶颈已悄然浮现。有研究机构预测,到 2028 年左右,用于训练 AI 模型的数据集典型规模将达到公共在线文本总估计量的规模。换句话说,AI 可能会在大约 4 年内耗尽训练数据。与此同时,数据所有者(如报纸出版商)开始打击对其内容的滥用行为,进一步收紧了访问权限,这将引发 “数据共享” 规模上的危机。为此,开发人员必须寻找变通之道。

- 科技日报

全面拥抱人工智能 —— 访 360 集团创始人周鸿祎

我国人工智能大模型具有广阔发展前景,但要在全球大模型产业竞争中赢得主动,一是要充分发挥我国制度优势,与国外通用大模型展开竞争;二是充分用好我国工业种类齐全、场景众多的优势,将大模型和各种应用场景结合,推动一场新型工业革命,这是实现发展 “弯道超车” 的关键。

- 经济日报

国产 AI 舞台,站满了 “90 后天才”

从资本到产业对人才的大手笔抢先押注现状来看,有关 AI 的比拼,无疑不止算力,而更在于人才。

- 科创板日报

“国产英伟达” 们,扎堆上市

因此,GPU 企业想要快速发展,必然离不开资本的助力,冲击上市仍是 “国产英伟达” 们获取资金弹药的重要途径。

而在等待资本市场的大门开启之前,它们也需要直面生存的考验。张建中曾直言,“摩尔线程目标为至少先存活 10 年”。在这场 “国产替代” 光荣而艰辛的征途中,中国算力企业的竞逐才刚刚开始。

- 财经天下 WEEKLY

冷眼与嘲讽之后,谷歌的 AI 大模型翻盘之路

谷歌正在逐渐夺回大模型竞赛的行业关注度和开发者认同,反垄断大锤还尚未真正落下,谷歌获得了一个难得的发展窗口来在新的技术革新潮流中暂时站稳脚跟,为下一个人工智能时代真正到来前做好准备。

- 锦缎研究院

AI “爆改” 快递行业的第二年

从简单的寄件、查件入手,到面向快递小哥打造 “知识库”、再到帮助完成业务信息的汇总整理,甚至到供应链的智慧控制,大模型在快递行业的能力正在被逐步释放。选择私有化部署模型、自研大模型的快递公司们都相信一点:大模型是值得的长期投资,它在快递行业的应用上限仍然有一个广阔空间等待发掘。

- 光锥智能

今日推荐

开源项目

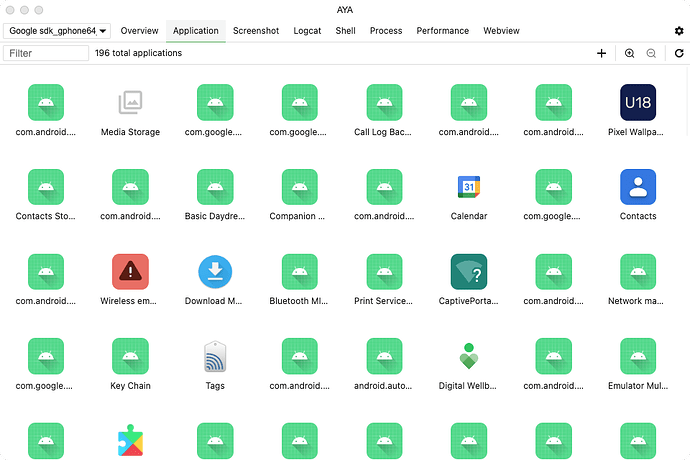

liriliri/aya

https://github.com/liriliri/aya

AYA 是一款内置 ADB 并基于其功能编写用户界面的桌面应用。相比于原始的 ADB 命令行输入,AYA 安装傻瓜,功能齐全,全图形化界面,一键操作,极大地提高用户效率。

每日一博

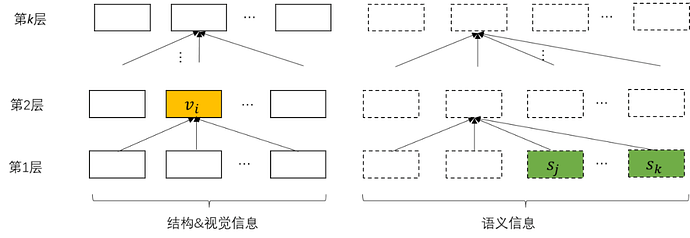

网页多模态建模思考

本文从网页理解业务出发,从多模态信息融合,预训练任务构建角度,探讨通用网页建模方案。首先,指出网页的特殊性,即从不同观察视角下,网页存在富文本、树形结构,和图层堆叠三种形态。在此基础上,对比了多种多模态融合思路的优缺点,给出一种较好的方案。进一步,提出多粒度、多维度的网页预训练方案;最后,探索了大模型时代,利用现有多模态模型,低成本的适配到网页的一种可行思路。

开源之声

用户观点

最强开源终端模拟器 Ghostty 正式发布 1.0:原生 UI 体验、采用 Zig 编写、速度飞快、支持 Mac 和 Linux、支持 GPU 加速

- 观点 1:什么玩意?不支持 windows?我今晚就去提 issue,炮轰作者

- 观点 2:不至于,README 里有写是有计划支持 Windows 的。终端模拟器不支持 Windows 是非常常见的情况

- 观点 3:zig 比 rust 吹实在

- 观点 4:只要 C ABⅠ 在行业上占大头,zig 就永远实在。zig 直接调用 C 真的很爽!

- 观点 5:完全可以理解,等下就去试试。Who care Windows?

- 观点 6:和 Rust 写的 Warp 比如何?Zig 应用越来越多,好事。

- 观点 7:Warp 性能不太行,输出多了卡, 不知道后续的版本会不会优化

- 观点 8:目前在用 wezterm,感觉真正的 killer feature 是 multiplexing,tmux 快捷键记不住。目前看 ghost 没有 multiplexing,也没有 tmux integration,期待。

- 观点 9:好吧,我还是用 WinTerm 吧

- 观点 10:你不觉得这玩意反应要慢半拍么,而且伪开源不让人放心。

- 观点 11:我看不懂源代码,所以不存在放心与否~

- 观点 12:不知道跟 wezterm 比起来怎么样

- 观点 13:用上了,之前用 wezterm,个人感觉比 wezterm 更简洁高效。两个都很好。

- 观点 14:可以替换掉 iTerm2 了

- 观点 15:我用 powershell7.5

中国 AI 的进步之快,让美国人开始怀疑现实了

- 观点 1:飘了

- 观点 2:哪来这么多反思哥反思姐?作为机器学习领域的从业者,国内 ai 领域实际上就是在突飞猛进的发展,海外各类先进模型和理论也至少一半是大陆出海华人的贡献。现在大环境不好,但不是国内从业者夜以继日的努力是网民一句话所能掩盖的!

- 观点 3:当然 DeepSeek 不太一样的是,它不太缺卡,2021 年就囤了 1 万张英伟达 A100,那会儿 ChatGPT 还没影呢,和 Meta 为了元宇宙囤卡却阴差阳错的赶上 AI 浪潮很像,DeepSeek 买那么多卡,是为了做量化交易⋯⋯

- 观点 4:阴差阳错,就好比你买了一把锅铲,本来打算是用来炒菜的,后来发现打老公也挺好使!

- 观点 5:中美 ai 发展的确差不多,期待落地

-–END—