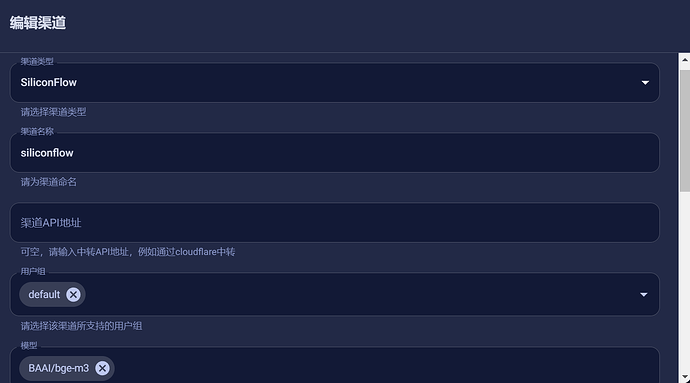

之前用openwebui,2H4G超开云跑不动 Embedding,最终本地部署+内网穿透到vps。(备用方案拉硅基流动api)

选择Embedding模型,用bge-m3

选择Reranker模型在超开云可以用BAAI/bge-reranker-base(openwebui好像不能拉api,如有实现方式请指正),如果佬友配置不错选择BAAI/bge-reranker-v2-m3。

最终配置是bge-m3+BAAI/bge-reranker-base

简单测试下来是单纯开bge-m3,1000道题库,有一定错误概率。如果是bge-m3+BAAI/bge-reranker-base,提升效果不错。

当然我不是程序员,只是本人实际使用过程,心得分享一下,欢迎指正和分享。

最后纠正下:bge-m3在我笔记本上,内穿到vps(超开云)。reranker重排模型在vps(超开云)上运行。bge-reranker-base占用并不大,2h4g跑的动

10 个赞

yqyan

(Grogu)

5

Open WebUI 的嵌入模型可以使用内置引擎拉模型就行(楼主推荐的 BAAI/bge-m3 值得推荐),也可以使用 Ollama 和 OpenAI 兼容接口的。

重排模型只支持内置引擎拉模型(同样楼主推荐的 BAAI/bge-reranker-v2-m3)的,不支持其它 API 接口的。

4 个赞

我这里一直存在问题。我通过one-api进行聚合,然后使用硅基流动的模型,一直提示 not iterable.

reranker重排模型在vps上,BAAI/bge-reranker-base,2h4g能运行。之前编辑帖子,手动打字太急,已经改正。

BAAI/bge-reranker-v2-m3模型,轻量云2H4G跑不动,需要更好的配置。

感谢佬友回复。这里纠正下,之前打字太急(家人催吃饭),是 BAAI/bge-reranker-base这个重排模型。

yqyan

(Grogu)

10

我一直用的是 BAAI/bge-reranker-v2-m3

我直接在oi里填硅基的api和key了。目前发现一个问题就是当我上传比较大的文档的时候,会存在明显的卡顿。服务器CPU都上90%了,是因为我的设置设置的比较大吗?

1 个赞

嵌入层批处理大小 (Embedding Batch Size) 先从16开始测试,慢慢加。

文本向量化我不是专家,给不了建议。

放弃了 还是使用lobechat吧 。lobe在文件处理上确实比oi好很多

个人知识库还是推荐 cherry studio 配合硅基流动;web 端推荐谷歌的 notebook lm