无需docker直接部署ollama,小白也能轻松玩转本地模型!

原教程地址:

小白教程 | 一步步跟着做即可

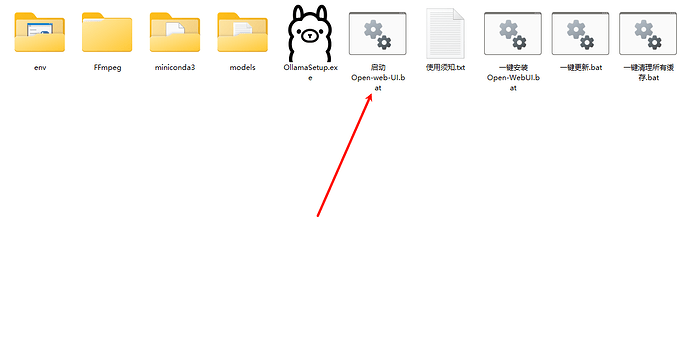

①下载并解压压缩包

https://r2u.newbefree.us.kg/OpenWenUI-0.4.7.7z

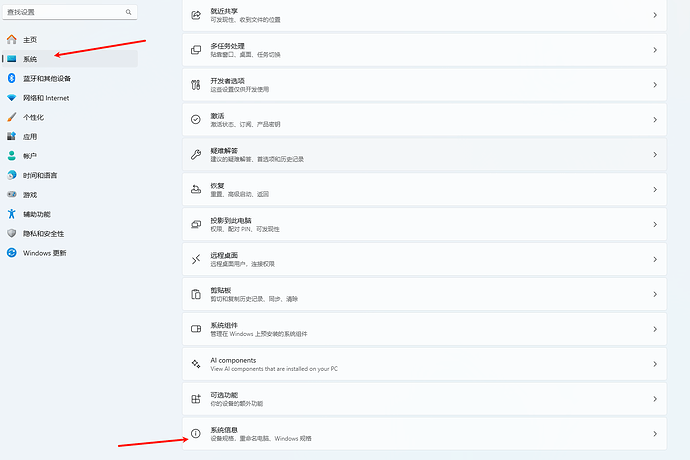

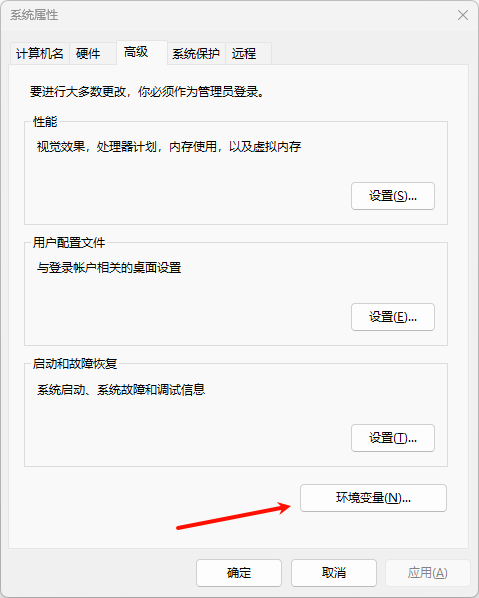

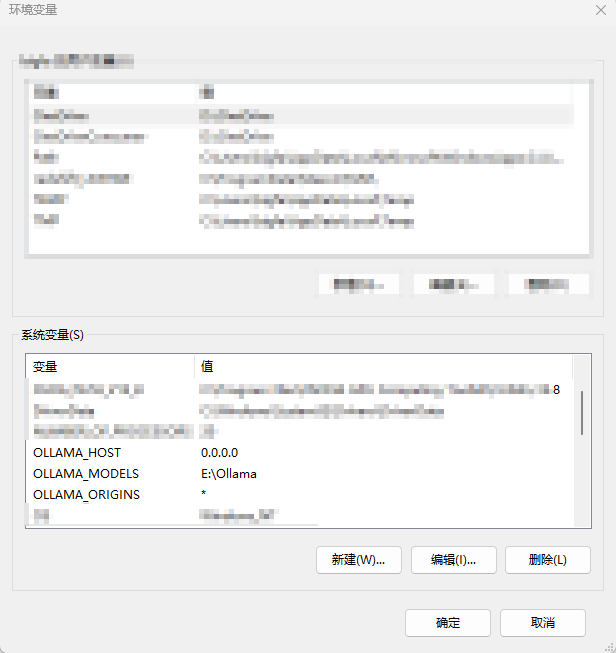

②设置环境变量 | 以 Win11 为例

》》新建三个环境变量

变量名、变量值分别为:

OLLAMA_HOST

0.0.0.0

OLLAMA_MODELS

E:\Ollama(自定义模型保存位置,按照自身需求设置路径)

OLLAMA_ORIGINS

*

③ 安装 Ollama | 可以是压缩包自带的,也可以重新去官网下载最新版

》》安装完之后右键点击“Quit Ollama”退出 ollama 后再重新打开,这一步是为了保证前面设置的环境变量能百分百生效

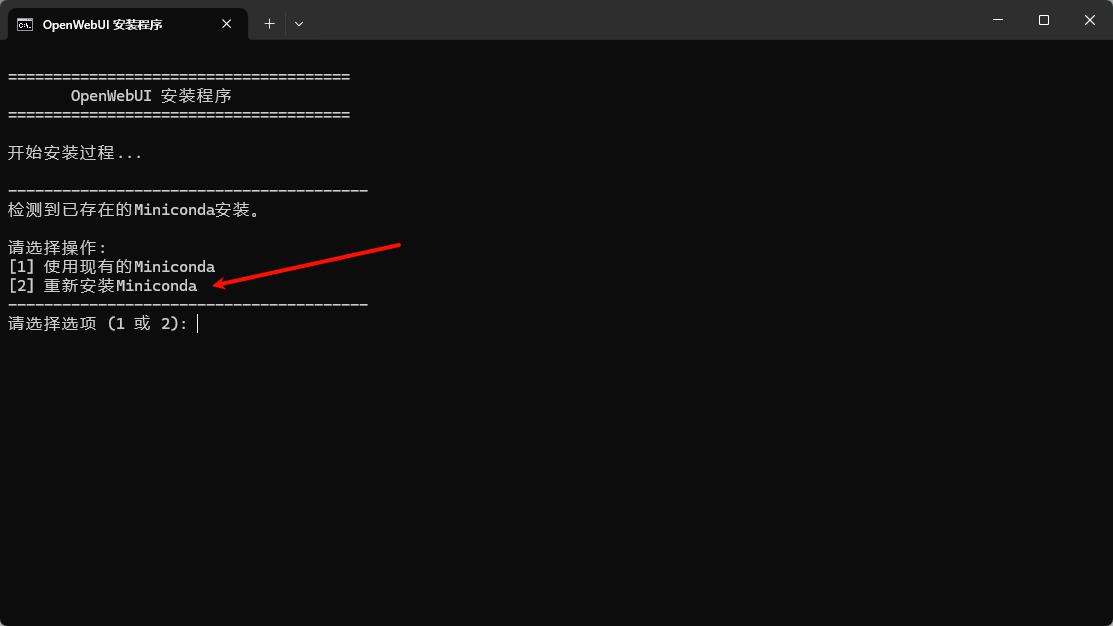

④点击“一键安装Open-WebUI.bat”

⑤选择“重新安装Miniconda”

⑥以上完成后点击“启动Open-web-UI.bat”

⑦需要更新则点击“一键更新.bat”即可更新 OpenWebUI

先关闭网页端和 .bat 程序

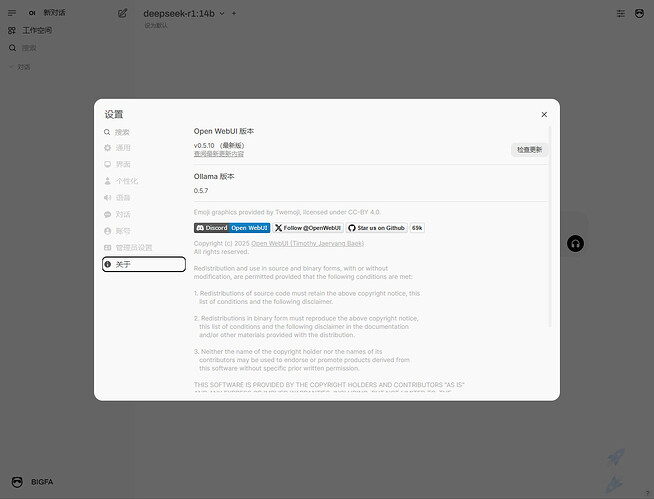

OpenWebUI 小白使用教程

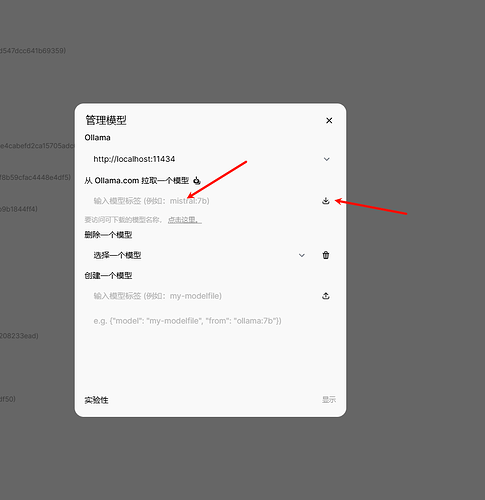

①管理模型:下载或删除

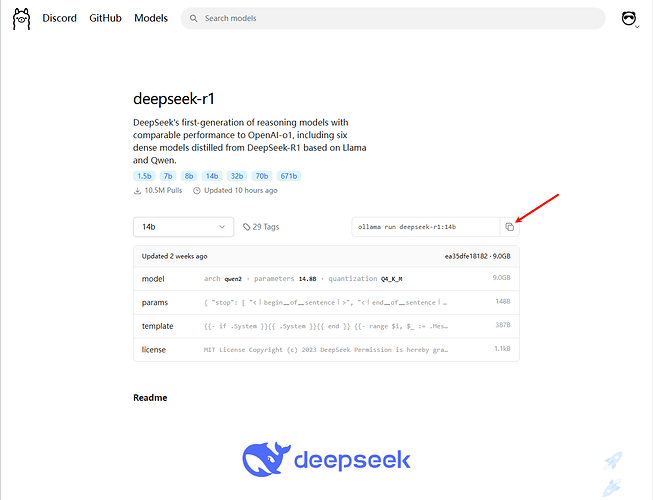

》》下载模型 | 以 deepseek-r1 14b为例

复制模型名称“ollama run deepseek-r1:14b”

》》方法一,直接在 openwebui 中直接下载

把“ollama run deepseek-r1:14b”复制到这里并点击下载即可

》》方法二,win+R 键,输入 cmd ,然后把“ollama run deepseek-r1:14b”复制进去回车即可直接下载

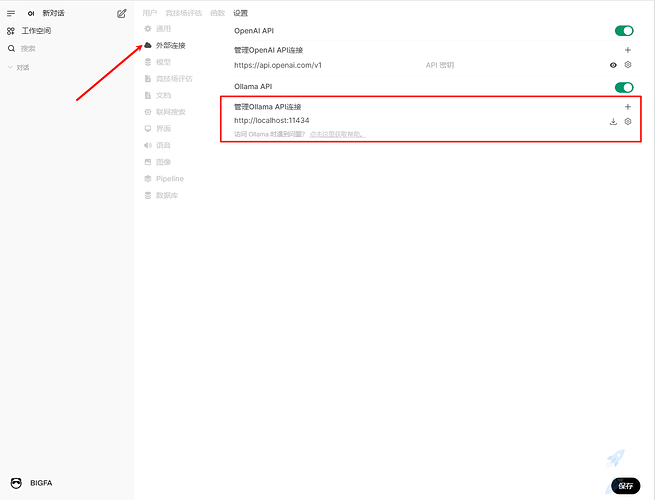

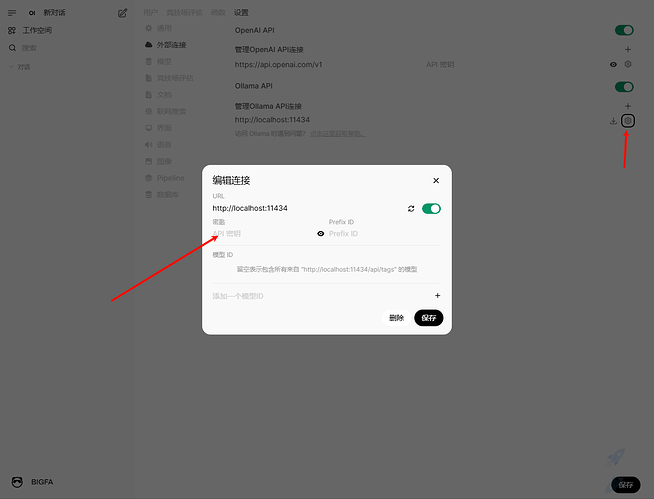

②调用本地 API

》》已经可以直接使用 | 不额外设置无需填写秘钥

调用地址为:

http://127.0.0.1:11434 百分百正确的调用地址

或

http://localhost:11434 一些工具能调用的地址