DeepSeek联网搜索非常快能出30-40条搜索结果,我使用OpenWebUI的联网搜索配置google pse之后很久才能出3条搜索结果,有无能够接近DeepSeek搜索速度的替代方案?

能配置 searxng 吗?

同问sss

openwebui可以修改搜索引擎和结果数量和并发数量,在管理界面

我用这个一直报error searching ,很奇怪

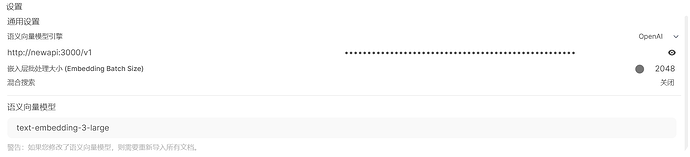

需要正确配置语义向量模型

也就是说,搜索引擎是可以用的 ,但是我的语义引擎出现问题,导致无法使用吗?

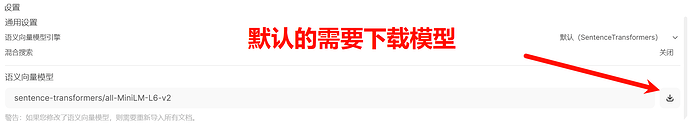

默认的性能要求高吗?我部署在小服务器上的

我部署在2c1g swap开1g,可以跑起来

还是比较推荐使用现成的,很便宜甚至免费:

- 硅基:

BAAI/bge-m3 - OpenAI:

text-embedding-3-small/large

好!谢谢!

还是要慢很多的。。。不知道将来会不会有直接本身支持联网搜索的模型,好像 kimi 的 api 可以?

Gemini 有,我现在改用带联网的 Gemini 模型了

佬,我问一下,使用硅基的话,也是选择openai吗,那个地址是填 cn结尾这个是吗?这样就不用下载了是吧,我注意到你的批处理大小是2048,默认是1,这个有讲究吗

使用默认的模型,下载是指:在服务器上本地运行一个嵌入模型。用其他的自然不用下载了。

使用硅基的嵌入模型,参考这个帖子的解决方案:Open WebUI中的语义向量模型引擎到底该怎么设置?求大佬教学

批处理大小和不同嵌入模型的能力有关,更多的批处理大小速度更快、质量更高。我目前只知道openai的模型最高支持到2048,你可以查阅更多资料学习一下

太慢了,没有实际使用价值

gemini在openwebui里怎么设置联网,我是用CF 把gemini转成openai的来用