huan

(焕昭君)

1

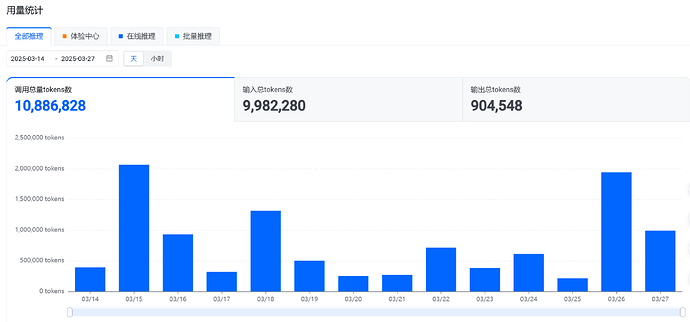

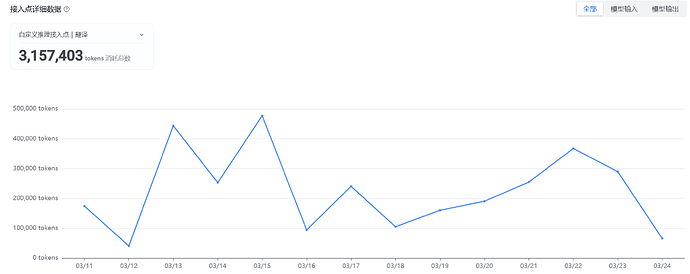

如图所示

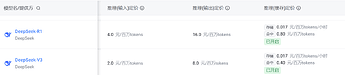

我发现的tokens消耗大部分是输入的。

沉浸式翻译用了三百万,DeepSeek-V3的日常聊天使用全部加起来用了四百多万。好在大部分是v3的输入价格。

隐藏内容

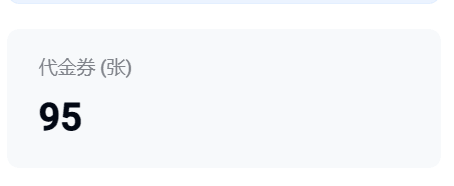

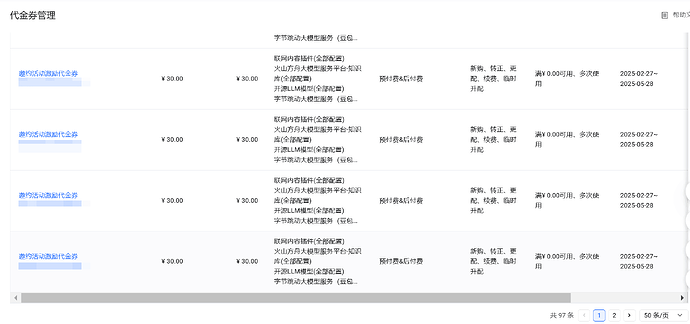

好在我 “颇有家资、富可敌国”

火山之前领了将近100张代金券,将近3000¥?

未来可能我会搭建个new-api站点提供公益api给大伙当福利挥霍光(尽情期待! 在学在研究了!),毕竟有效期只有三个月可惜了。

开个缓存看看能不能节约一点

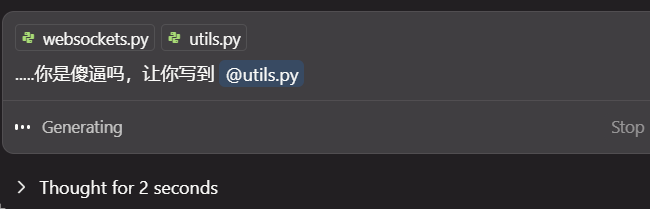

感觉现在的cline还是MCP,差不多就是提示词工程

使用一大堆长的内设提示词达到相应的效果。

mcp体验里我觉得cline好,能细颗粒度设置同意权限、能使不支持function calling的模型支持MCP比如deepseek、不会弹出一堆黑框命令行(说你呢cursor,MCP体验极差,我才开五个MCP每次启动都跳一堆黑框框);cherry studio的MCP也还得加强,可以去偷点cline藏的提示词。

41 个赞

我以为就我的cursor会弹出黑框看来还是有其他人的真是无语了就是

12 个赞

dadaozei

(我是个大盗贼,什么也不怕)

7

哈哈,牛逼。我最多一天搞了 200w。不过那是极特殊情况。至今也没有达到佬友这种月消千万级别的。

11 个赞

huan

(焕昭君)

8

看它后续能不能优化了,

不过目前看来也是没办法的,毕竟agent,ai差不多是处理文本内容, 既要马儿跑,又要马儿不吃草,不是这么容易的事情。我看爬爬虾大佬抓包,本质其实是命令行一堆文本内容,MCP服务返回的接口调用很多信息的。而且更别说Deepseek这种不支持function calling的更加消耗tokens了需要用更多提示词达到那个效果。

9 个赞

huan

(焕昭君)

10

怎么消耗的这么夸张?  干啥了呢?我能想象到巨量消耗要么是MCP服务,要么是大量的国外英文书籍和文献翻译。不过这么大量消耗如果不需要实时性可以用火山那个批量推理。

干啥了呢?我能想象到巨量消耗要么是MCP服务,要么是大量的国外英文书籍和文献翻译。不过这么大量消耗如果不需要实时性可以用火山那个批量推理。

还是代理api发出来给佬友们当福利了?

3 个赞

leeorz

(近战法师)

12

llm的注意力珍贵啊,我始终认为cline的做法太辣鸡

所以缩紧上下文,变成弱智cursor,这做法更让人不耻

leeorz

(近战法师)

14

cursor 那是自己作死,他本身有好方法的,去试试站里新推荐的 augmentcode ,体验不错,目前白嫖中

1 个赞

举个简单的例子,现在长上下文已经是个废物了cursor

1 个赞

huan

(焕昭君)

16

是这样的,看看后续什么时候优化。体验很差。

目前我用的三家,就cline的MCP体验最好。cherrystudio试了一下发现还得预设一些强力提示词才能达到cline的一小部分功能,比如让ai自动调用MCP非敏感读写删除操作别问我。而其他功能让不支持function call的模型也能用MCP就不知道了。

其他支持MCP的我没用过就不知道了,等大佬们评测推荐

2 个赞

huan

(焕昭君)

18

你多用用cline和搞搞MCP,还有沉浸式翻译多看点英语网站,自然消耗量就多了

2 个赞

huan

(焕昭君)

19

augment跟cline和cursor比怎么样?我看佬友们评价跟cursor功能差距还有一定。

还有对MCP的支持怎么样?别学cursor弹一堆黑框框命令窗口。最好学学cline做法可以细颗粒度控制自动同意权限。

2 个赞