老哥能看看你配置文件吗?你把key打下码,我也是用这个大佬的站点,但我用不了,我看看配置文件我差在哪

大佬们遇到过这个报错么:

2024/05/20 11:08:57 request completions failed: {“error”:{“message”:“This model’s maximum context length is 4093 tokens, however you requested 5901 tokens (5401 in your prompt, suffix; 500 for the completion). Please reduce your prompt, suffix; or completion length. (request id: 20240520110854704046673vm7of75H)”,“type”:“invalid_request_error”,“param”:“”,“code”:null}}

使用的是idea开发

我只是简单的测试了一下排序算法,它每次耗费的不多,但是并发高。

估计如果实际使用的话耗费的不会低。

而且对API站点要求也高。

块引用Cocopilot新配置 - #40,来自 adonis.lau

换个支持gpt-3.5-turbo-instruct的API渠道。

块引用Cocopilot新配置 - #41,来自 EmptyKYP

配置文件就是上面的config.json

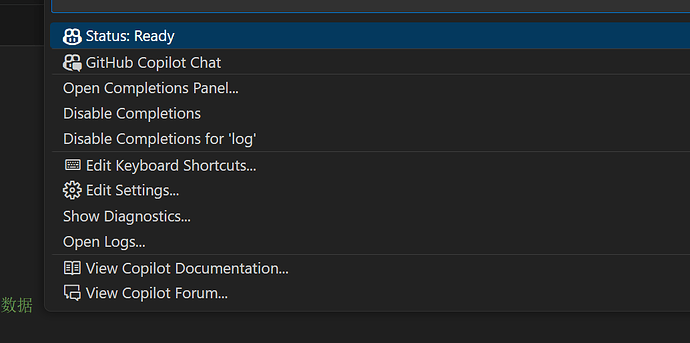

如果是vscode你可以点击右下角的copilot图标,查看一下日志(OpenLos),看看跟我上面发的有什么不一样,如果路径问题要在插件配置(settings.json)里改一下

这个好像目前没有解决办法,gpt35instruct最大支持4093,切割一下文件,选关键代码发给他会好一点?

我意思codex_api_base和chat_api_base参数要不要?codex_api_key和chat_api_key呢?

找到问题了,是新版本copilot插件把最大token数给写死了,换旧版本就可以了

都需要的,我是下面的配置:

//代码补全模型配置,默认模型gpt35turbo-instruct且无法修改

"codex_api_base": "https://oai.itsfurry.com/v1",

"codex_api_key": "sk-***",

"codex_api_organization": "",

"codex_api_project": "",

"codex_max_tokens": 4093,

//聊天模型,无要求,国产海外都可以

"chat_api_base": "https://api.deepseek.com/v1",

"chat_api_key": "sk-***",

"chat_api_organization": "",

"chat_api_project": "",

"chat_model_default": "deepseek-coder",

"chat_model_map": {}

好的.谢谢指导

代码补全只有deepseek这个吗?

代码补全需要gpt-35turbo-instruct模型,只要你有这个模型的api站点,哪个站点都可以。

这个好像没有哪个站点支持吧

看你们都好牛

没啥大毛病,除了智力有点问题外其他应该都还好。

copilot 应该有优化和专门训练

直接接 OAI 或者 其他AI除了表现能力差了一点以外没啥大问题

![]()

![]()

![]()

学习了,docker 构建尝试下

大佬,再出个教程呀,c 其他ai的

mark

我只能说泰COOL辣

总结的很棒

牛背!!