效果确实挺好,但是这玩意儿的token消耗实在太恐怖了一点:

输入是加起来30几页的PDF,搭建知识图谱+回答了不到十个问题就花费了我接近250万的token。

试下来,甚至仅仅是回答一次都要花费接近10万token,很难想象要是使用更大的数据量构建会花费多少token…

还好提前改成了用deepseek,不然用它默认的gpt4怕是花费直接爆炸![]()

效果确实挺好,但是这玩意儿的token消耗实在太恐怖了一点:

输入是加起来30几页的PDF,搭建知识图谱+回答了不到十个问题就花费了我接近250万的token。

试下来,甚至仅仅是回答一次都要花费接近10万token,很难想象要是使用更大的数据量构建会花费多少token…

还好提前改成了用deepseek,不然用它默认的gpt4怕是花费直接爆炸![]()

这个听上去不太可能吧

graphrag是搭建知识图谱消耗巨大吧,回答问题为什么也会有这么多token,deepseek的限制好像就是128k

效果确实挺好

效果确实挺好

效果确实挺好

这才是最重要~

https://microsoft.github.io/graphrag/posts/query/notebooks/global_search_nb/

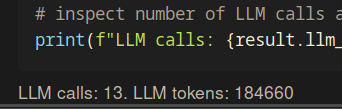

它这个回答问题会回调llm很多次,比如在上面这个微软官方给的例子中:

因为参数设置不同,它这个消耗甚至比我的还高

主要效果并没有好上很多,但是token消耗是好几倍 ![]()

消耗这么多啊,离谱

就是这个缺点,消耗量太大,而且还有很多缺点,我感觉补充新知识也麻烦,牵一发动全身,重新构建大量计算,对于公司数据就是天文数字

刚刚本来想把公司nas里面的资料来一下,想了想几个t消耗gpt3.5可能都顶的上来linux共享一天api了 ![]()

这东西是把全文本发出去了,

他回复引用的知识太多了

From #develop:ai to #share