前段时间写了一个 GPT面试助手 当时只有终端里面输出内容,佬友们给了很多改进的建议.

昨天周一,抽空把佬友的想法实现了一下,今天来更新.

这个项目后续又更新了一些功能,未来肯定会上更多的功能的.

目前主要痛点:

- ocr识别数学公式准确率不高,导致GPT有时候会读不懂题进而乱回答

- 目前回答的GPT味太过严重, 这边我会爬取一些题解面经作为

RAG外接,同时优化prompt - GPT的正确率还是太低,做一个

claude和GPT,甚至其他模型相互验证 - 最重要: 优化部署流程部署难度,致力于让每个人都能简简单单的用上(考虑做一个用户端的界面并打包)

按照惯例,求个github star.

对应的代码仓库面试client端, 面试server端, 因为论坛貌似不支持gif,所以还是github有更好的阅读体验.

功能展示

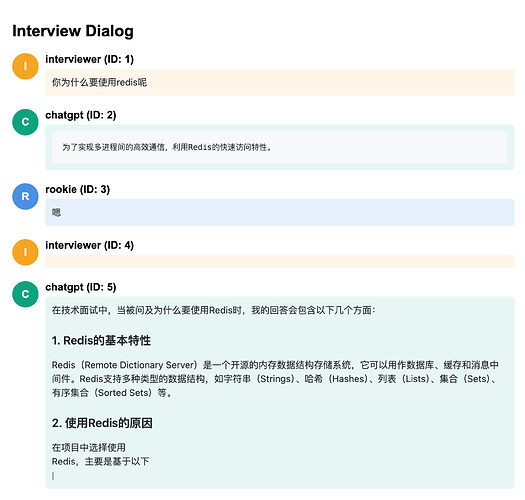

下图讲解, 通过播放本地音频,模仿系统内声音输出 你为什么要使用消息队列呢?

web 监听到 你为什么要使用消息队列呢? 内容并流式输出

ChatGPT(大模型助手) 流式输出相关问题的答案.

支持 本地部署 和 服务器部署. flex 布局,在 手机 平板 电脑 下的具有良好的显示效果

https://cdn.professoryin.online/aower-gpt/2024/08/2a44f05ece24ef4cd0c6dd771fd91d14.gif

RAG 展示

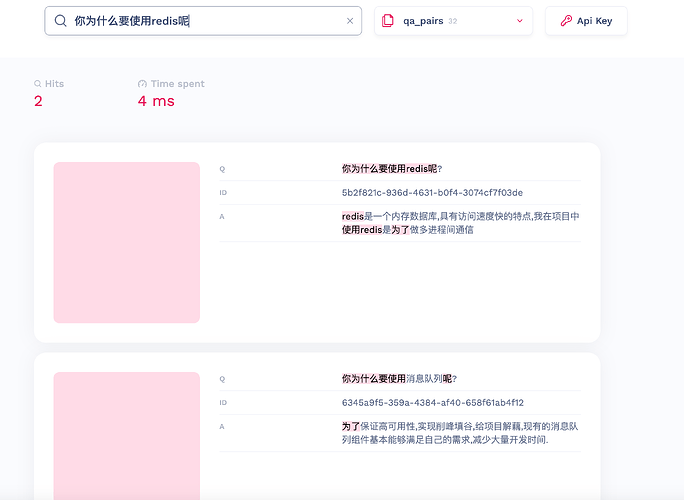

下图讲解, 支持将你预设好的问答内容存入RAG数据库,在询问ChatGPT(大模型助手)之前会先搜索RAG数据库.

如何使用 RAG 知识库

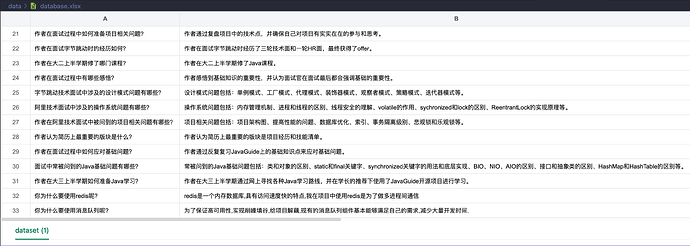

- 在

.env文件内, 设置RAG_ENABLED=True - 在

data文件夹下,放入你的知识库xlsx文件, 会递归遍历所有的xlsx文件 - 文件格式如下: 有两列, 第一列是

Q,第二列是A. 分别对应问题和回答. (生成知识库文件可以使用FastGPT导出的内容) - 重启

docker容器,docker-compose restart

Q: 能否将我的项目进行存放在 RAG 知识库中呢?

A: 目前需要自己处理, 自己询问 GPT 或者自己编写对应的问题, 或者你可以修改网络上 AI审查代码的项目 修改里面的prompt, 让其生成你自己项目的 RAG 知识库.