douhao

(逗号)

1

一、搭建cocopilot,使用始皇的Chat2API和deepseek

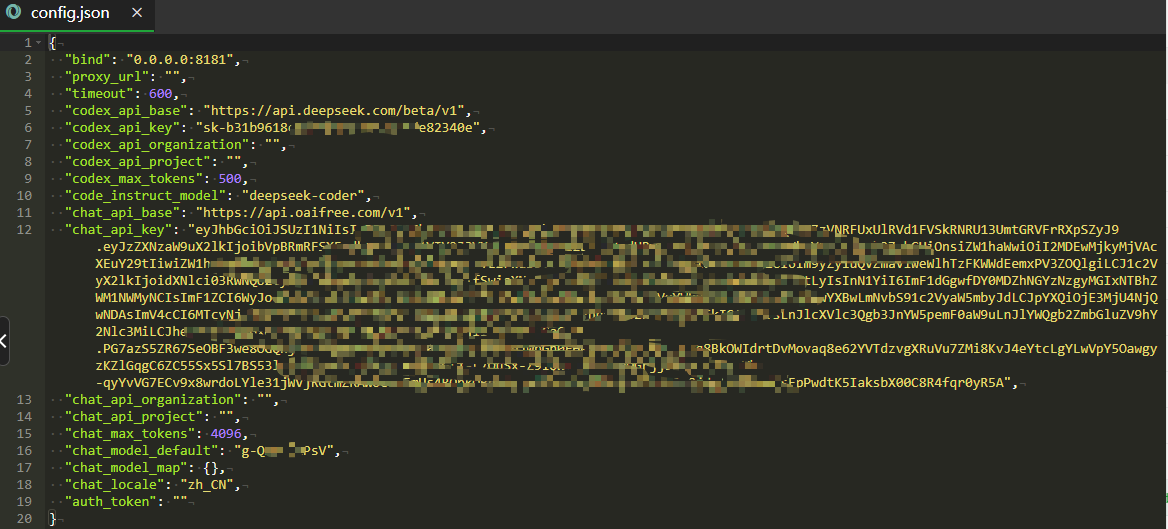

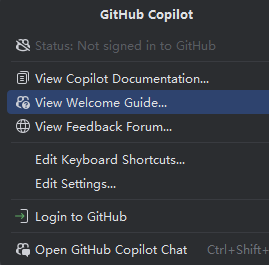

- 看了各位大佬的帖子,用deepseek的API和始皇的Chat2API搭建好了cocopliot服务;可以实现github cocopilot中使用deepseek的自动填充代码,同时用自己Plus账号的Chat2API实现对话,关键是对话模型可以选择GPTs的自己训练的模型,配置文件如下:具体搭建用cocopilot喂饭级教程,搭配oaipro,再也不加班! 这个帖子,我只是改成始皇的chat2API,感谢始皇和@浪里小白条。

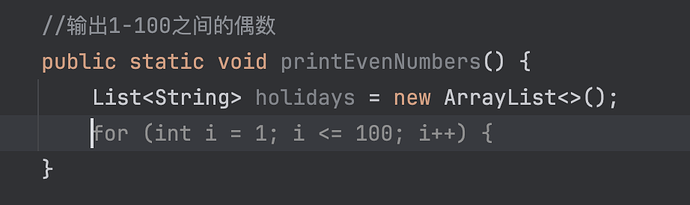

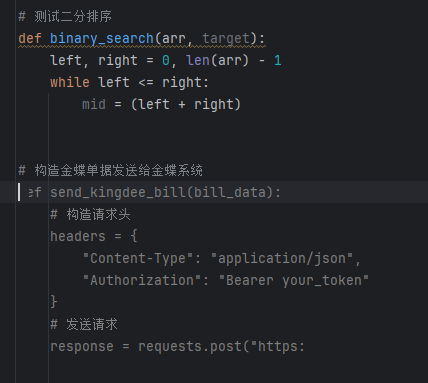

- 刚好我用deepseek时,官网提示可以用continue这个在补全代码,支持continue,我就试了下,感觉速度飞了,之前用deepseek在GitHub copilot中还是有点慢的要1-2s,用chat2API更不用说了,得要10s;

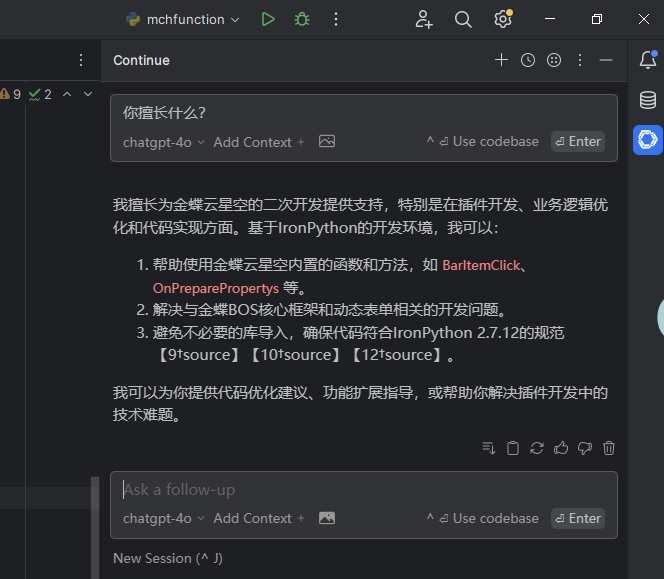

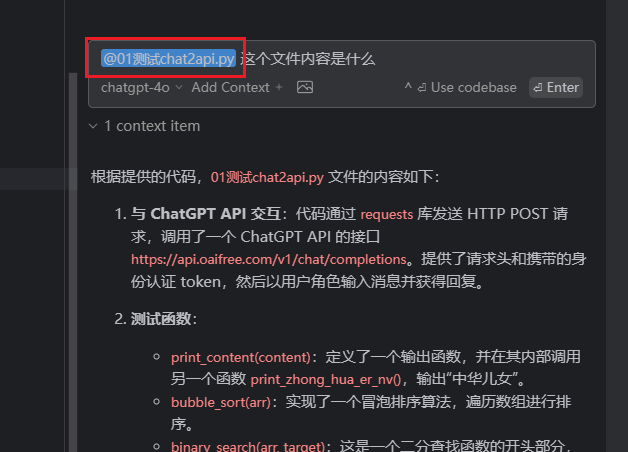

- 我先给大家看下效果,deepseek的代码补充和chat2API的问答:这个我是用的始皇的Chat2API,反应速度4s,真的不慢了

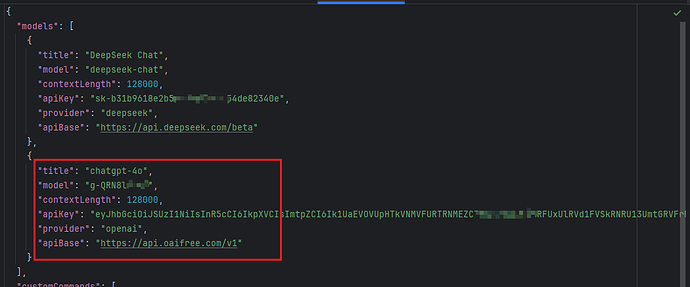

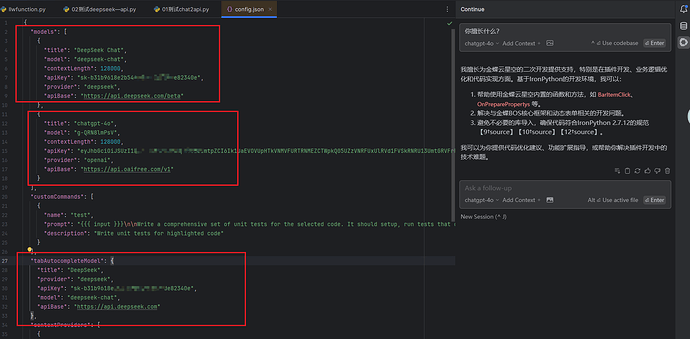

- 配置文件:大家可以看我用的是gpt4的GPTs的自定义模型,这里需要先把自己的Plus账号有chat2API,参照始皇的教程,然后你看它的回答也是我训练后的不是统一的回答,我是做了一个专门用金蝶星空二次开发的GPTs(注意:可能之前的最之前新建的GPTs可能用不了,需要新建一个GTPs,我是23年建的好像不行;)

4.deepseek的自动填补代码速度也很快,比github copolit的速度快多了;但是也有问题,continue才开始,只是dev插件,所以很多不好,比如没有配置好就卡死,我配置了jetbrains家的pycharm和Intellij IDEA,和VS code,都可以跑,过程有卡死,关闭软件重新打开就可以了;以下是我Pycharm的配置文件:主要注意图中的3个地方;vscode 自动生成的,不需要怎么改,jetbrains家要自动改配置文件

- 具体配置教程地址:

awesome-deepseek-integration/docs/continue/README_cn.md at main · deepseek-ai/awesome-deepseek-integration · GitHub

官方文档:Introduction | Continue

感谢以下帖子,我是参考你们的帖子搭建的:

https://linux.do/t/topic/160750

9 个赞

douhao

(逗号)

3

是的,配的过程总是卡死,配合好就还好,我先试用下  ,关键是速度真的快!

,关键是速度真的快!

1 个赞

主要是卡死要重启idea,真是要命,所以就算了哈哈

Jason

(逸昂)

11

我用的groq,好快,好用啊!!!他生成终端命令还可以一键点击执行,连同复制都省了。

douhao

(逗号)

12

现在是dev版本,后续出调优后在看看,官方都没有介绍这个插件的内容,还在测试阶段

1 个赞

vsvskkk

(活到现在的秦始皇)

13

continue 的缺陷只有一个,就是代码信息缓存处理。github copilot 程序有一个优势就是内部有处理(会多个进程在后台运行)。会选择性筛选代码和提交,能更有效的生成你需要的代码。这块能力比 continue 强。

但是continue 速度快确实没得说。不过本地部署copilot 效果其实和 continue 一样,速度也很快。

1 个赞

vsvskkk

(活到现在的秦始皇)

19

把始皇的override 项目部署到本地就可以。不要用别人发的公交车。搜一下本地部署override 就行