在我最初加入 LINUX DO 论坛时,我便注意到了社区的总体原则,其中提到了一点让我非常疑惑:

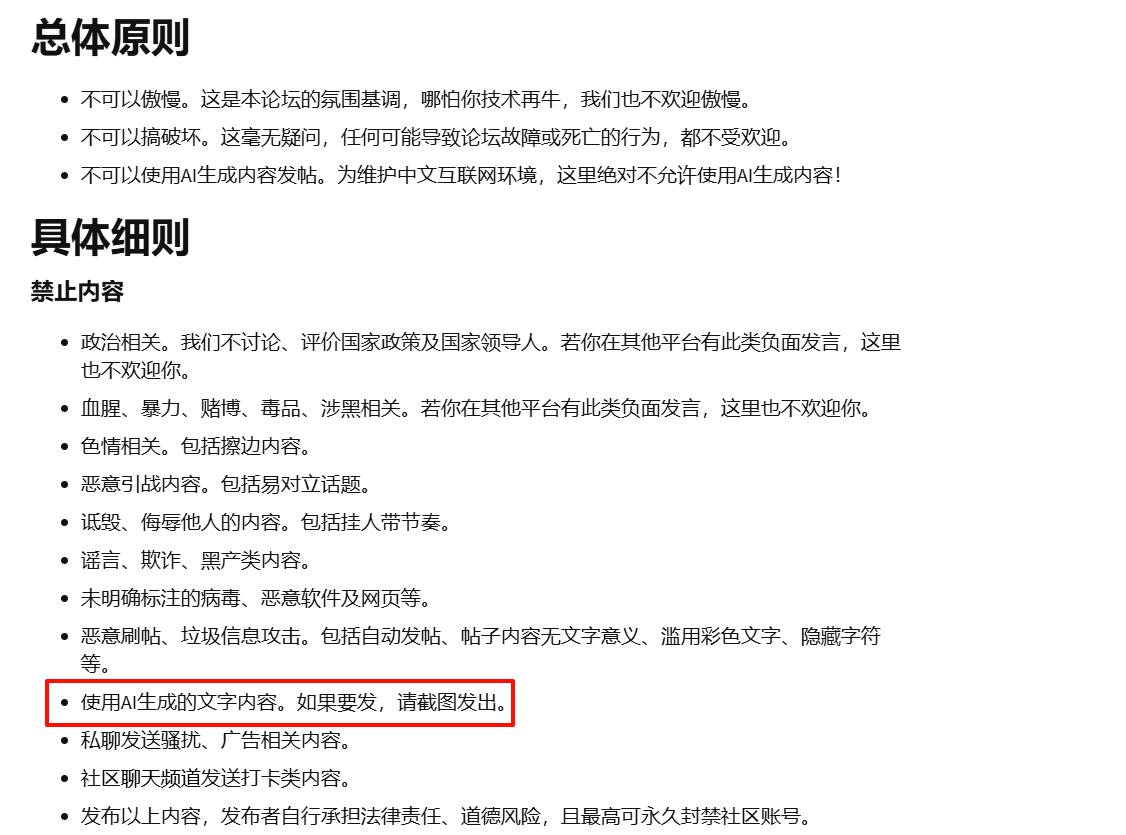

不可以使用AI生成内容发帖。为维护中文互联网环境,这里绝对不允许使用AI生成内容!

社区对 AI 生成内容的态度是 绝对不允许

理由是 为维护中文互联网环境

所以我们可以推断出 LINUX DO 社区的观点:AI 生成的一切内容都会对中文互联网环境构成损害。

而我认为这个观点存在错误,反驳理由如下:

- AI 生成内容并非必然对中文互联网环境构成损害

- 问题的核心不在于生成工具,而在于内容本身的质量

- 完全禁止 AI 内容,可能不符合技术发展的潮流

- 对“中文互联网环境构成损害”的观点缺乏证据

AI 工具的 正确使用 可以丰富论坛内容,提高讨论水平,并且这 符合技术发展潮流 ,对于 LINUX DO 这样的技术社区而言,想必是十分甚至九分重要的。

因此我建议:与其全面禁止,不如设立合理的使用规则

叠个甲:以上只是个人的看法与建议,采纳与否和我利益无关

只是刚好我的帖子被举报了,我怀疑是有人认为我在用 AI 创作,所以我想顺便来提提建议

18 个赞

neo

(Neo)

4

你这个内容是 AI 生成/润色 的吗?那请截图发出。

AI 的训练需要高质量的预料,而语料来自于互联网。众所周知中文语料本来质量高的就不多,再掺杂 AI 生成的内容,只会越训练越傻。

15 个赞

Qiner

(林黛玉倒拔垂杨柳)

6

然而 LINUX DO 本质上是始皇的个人网站 (不仅没有卖会员啥的还一直免费给大伙用 GPT-4),你这是跑到别人家客厅说这客厅装修风格不对你觉得氛围灯应该如何装才更好。。

然而 LINUX DO 本质上是始皇的个人网站 (不仅没有卖会员啥的还一直免费给大伙用 GPT-4),你这是跑到别人家客厅说这客厅装修风格不对你觉得氛围灯应该如何装才更好。。

17 个赞

Qiner

(林黛玉倒拔垂杨柳)

7

有识别的能力,但没几个搜索引擎会奢侈到遍地爬 OCR 去建立索引。。

2 个赞

CRI4250

(虚无)

8

学了个新词! 研究AIGC

Garbage in garbage out(可以去了解一下)

2 个赞

因为我觉得存在错误就要及时改正,我之所以提建议也是出于我对 LINUX DO 论坛的认可

的确,我不知道这是个人论坛的性质,但即使是个人论坛,也不妨我们提提建议吧?而且没有人在抗议和抱怨,只是建议而已

2 个赞

错误可太优秀了,你要是真觉得这是个错误,应该拿出的是“证据”而不是“理由”就像你说

一样

5 个赞

对于这个观点我也有不同的看法  如果你愿意和我讨论一下的话可以展开看看,不愿意的话就不必展开了,我们都不希望因为这种小事产生纠纷

如果你愿意和我讨论一下的话可以展开看看,不愿意的话就不必展开了,我们都不希望因为这种小事产生纠纷

谨慎展开!理性讨论

观点

的确,中文语料质量高的不多

但这并非中文互联网环境比英文互联网环境差

互联网环境是非常非常庞大的生态系统,质量高低的差异不会有多么明显

那到底是什么让中文 AI 训练效果差呢?

是数据集的规模

是因为中文互联网的规模比英文互联网的规模小得多,比例是 1:4 的天差地别。

支撑材料

中文互联网规模较小: 根据 CNNIC 的报告,截至2024年6月,中国网民规模近11亿人,互联网普及率达78.0% 。相比之下,全球互联网用户总数约为50亿人,英语用户占据主导地位。这表明,中文互联网的规模相对较小。

中文数据集规模不足: 上海人工智能实验室发布的 “书生·万卷 1.0”数据集 ,包含约2.2亿个中文文档,数据量仅466.54GB 。相比之下,主流英文数据集的规模更大,导致中文AI模型在训练数据量上处于劣势。

中文语料匮乏影响AI训练: 谷歌大模型一出闹剧,揭开中文数据荒-虎嗅网 报道指出,全球大模型中,中文语料仅占1.3%,而主流数据集大多以英文为主 。这进一步说明,中文数据集规模不足是影响AI训练效果的关键因素。

我真的很乐意跟大家交流观点,但希望坛友保持理性,不要用低级的讽刺如褒词贬用这种手段对我进行人身攻击,大家都是玩互联网的,表达的什么意思心里都有数。

Crixs

13

为什么大家那么不喜欢CSDN,无外乎那边都是内容农场。AI生成的内容再去训练AI就会:

neo

(Neo)

15

如果按照你的说法,完全可以通过 AI 去生成中文语料的嘛。那岂不是几天时间就能生成成吨的语料吗?又怎么会有所谓的中文语料不足呢?

1 个赞

libook

(libook)

17

你发的AI生成内容会被AI重新爬取用于训练AI自己,这样会让AI逐渐劣化,哪怕AI生成的内容绝大部分是正确的,仅存的一点点错误内容也会在多次迭代中被强化。

这个问题早在大模型火起来初期就已经被很多研究机构发现了,曾经大模型因为这个问题爆发了较为显著的劣化。

另外,如果你能确定AI生成的内容是完全正确且优质的,那么你就完全可以不依赖AI来自己写一个内容;但现实情况是大部分人都会默认AI生成的内容是可靠的,不再进一步核实和推敲。

现行论坛制度下,是可以使用AI生成内容的,但要求必须以截图的形式发布。

3 个赞

neo

(Neo)

19

那何不从L站开始建立一个高质量的语料库呢,这件事什么时候做都具有意义。

L站只是禁止文字的 AI 生成内容,截图发出来就可以了。

7 个赞

yyy3

(yyy3)

20

反问:你说的“正确”如何定义?

你的反驳理由就不说了,槽点挺多的。属于看了原则但没完全看

2 个赞