synbio

(Schrödinger)

1

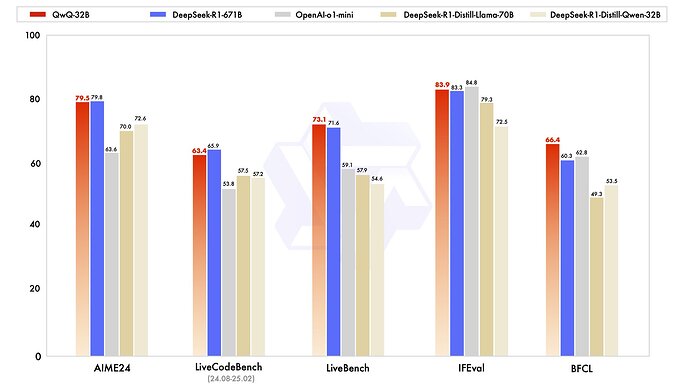

今天发布了 QwQ-32B,这是我们的新推理模型,它只有 320 亿个参数,可以与 DeepSeek-R1 等尖端推理模型相媲美。

博客: QwQ-32B: Embracing the Power of Reinforcement Learning | Qwen

高频: Qwen/QwQ-32B · Hugging Face

模型范围: modelscope.cn/models/Qwen/Qw…

演示: huggingface.co/spaces/Qwen/Qw…

Qwen 聊天:

chat.qwen.ai

这次,我们研究了扩展 RL 的方法,并基于我们的 Qwen2 取得了一些令人印象深刻的成果。 5-32B 。我们发现 RL 训练可以不断提高性能,尤其是在数学和编码方面,并且我们观察到 RL 的持续扩展可以帮助中型模型实现与巨型 MoE 模型相媲美的性能。欢迎随时与我们的新模型聊天并向我们提供反馈!

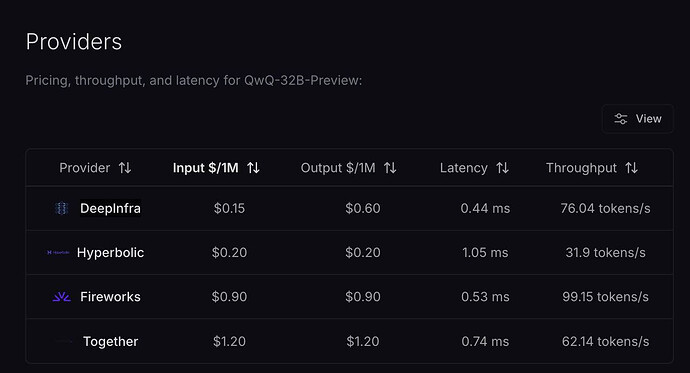

更新下价格

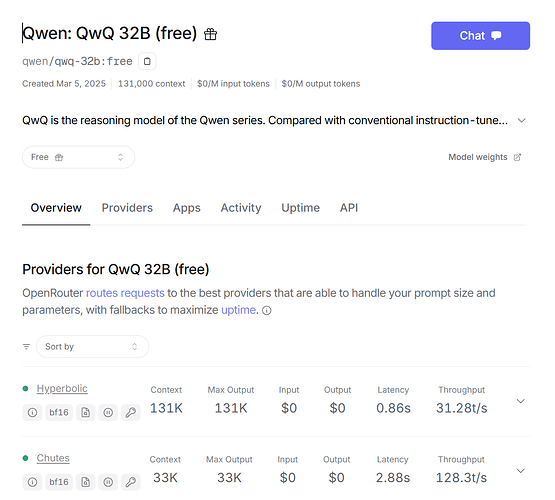

Openrouter上线了,免费

35 个赞

Juya

4

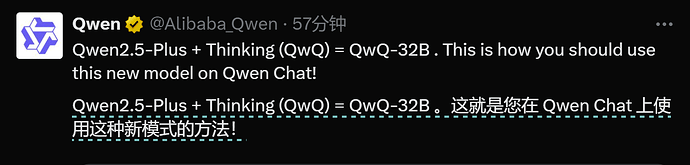

补充一下:在线体验可以在 Qwen Chat里面选Qwen-2.5-Plus并选择QwQ,此时会调用QwQ-32B。

8 个赞

eugeneL

(eugene)

8

不拉高规模就只能变成特定领域模型,agi 还是要烧显卡

2 个赞